Tous les investissements dans des technologies de soutien à la conformité doivent comporter un volet axé sur l’application de mesures de sauvegarde permettant d’en assurer le fonctionnement adéquat et efficace. Par exemple, l’apprentissage automatique peut aider une entreprise à détecter les tendances en matière de fraude dans ses transactions de vente ou à repérer les fournisseurs susceptibles de lui occasionner des problèmes, mais l’exploitation de données tendancieuses ou insuffisantes peut se traduire par l’obtention de faux positifs.

Les criminels tirent également parti de l’IA. Les systèmes d’IA peuvent servir à mettre au point des logiciels malveillants sophistiqués, à mettre à profit les leçons à tirer de cyberattaques infructueuses et à mettre au point des campagnes d’hameçonnage plus crédibles. Les entreprises qui ont recours à l’IA et à l’automatisation pour détecter ces cyberattaques et y répondre sont plus à même que les autres de repérer beaucoup plus rapidement les tentatives de violation de données dont elles sont victimes, ce qui, selon une étude réalisée par IBM, leur permet de réduire de près de 2 M$ US les coûts engendrés par de telles violations8. Malgré cela, moins de la moitié des entreprises sondées prévoyaient accroître leurs dépenses d’investissement en cybersécurité après avoir été victimes d’une intrusion dans leurs systèmes.

Les entreprises doivent aussi envisager de dépenser davantage pour leurs contrôles internes, lesquels permettent de restreindre l’accès aux données et d’assurer la conformité aux obligations de reddition de comptes. L’application de contrôles inadéquats constitue la principale menace interne signalée dans le cadre du sondage EI Studios qu’EY a commandé en 2023. L’intégration des flux de travail à des contrôles intégrés permet de réduire les erreurs et la fraude, ainsi que d’établir des tableaux de bord numériques de la performance en matière de conformité qui présentent des informations détaillées sur les principaux secteurs de risque.

Grâce à l’analytique avancée, une entreprise peut aussi intégrer la gestion des risques à la gestion de sa stratégie et de sa performance. Par exemple, suivant ce qui ressort du sondage sur les risques qu’EY a réalisé en 2023 auprès d’administrateurs des quatre coins du monde, les conseils d’administration qui s’appuient sur une analyse exhaustive de l’exposition aux risques liés à de nouveaux scénarios peuvent plus facilement déterminer si les stratégies et les modèles d’affaires de leur entreprise sont viables ou non, ce sondage ayant également révélé que ceux qui s’avèrent particulièrement résilients tirent parti efficacement des données et des technologies aux fins de la détection rapide des risques et de l’amélioration du processus décisionnel.

Établissement d’une stratégie de gestion durable des données et des technologies cadrant avec les valeurs organisationnelles fondamentales

Bien des entreprises peuvent considérer que l’exploitation responsable des technologies ne constitue pas toujours une priorité stratégique. Près de la moitié des répondants au sondage EI Studios qu’EY a commandé en 2023 ont indiqué que leur entreprise ne disposait pas d’une stratégie de protection de la confidentialité des données, s’agissant pourtant d’un domaine qui, dans la plupart des pays et territoires, fait l’objet d’une réglementation adéquate en vertu de laquelle une saine gouvernance des données doit être appliquée.

Les entreprises doivent se doter d’une stratégie et d’une vision globales de gestion éthique des technologies et des données, tout comme elles ont été nombreuses à le faire à l’égard de leur programme de durabilité. La lenteur des progrès accomplis dans ce domaine est toutefois alarmante. Selon le sondage sur les risques qu’EY a réalisé en 2023 auprès d’administrateurs du monde entier, moins du tiers des administrateurs considèrent que le conseil d’administration de leur entreprise effectue une surveillance très efficace des risques liés à la transformation numérique.

Les entreprises doivent absolument se doter d’un énoncé de mission leur permettant d’évaluer la mesure dans laquelle elles assurent une gestion efficace et défensive des technologies et des données, dans une optique cadrant avec leurs valeurs fondamentales. Par exemple, Adobe a communiqué clairement son engagement à faire progresser l’exploitation responsable des technologies axée sur la promotion des intérêts sociétaux. Dans son énoncé de principe sur l’exploitation éthique de l’IA, le fabricant de logiciels présente les mesures qu’il met de l’avant pour éviter que l’IA génère des informations tendancieuses préjudiciables et s’assurer que ses travaux cadrent avec ses valeurs9.

Pour sa part, Microsoft s’appuie sur une approche de création de solutions d’IA responsables et fiables qui reposent aussi bien sur des considérations d’ordre éthique que sur des perspectives de reddition de comptes10. L’entreprise exhorte les développeurs de technologies à se doter d’un organe d’examen interne ayant la responsabilité de transmettre des lignes directrices et d’assurer la surveillance des systèmes d’IA, de sorte qu’ils répondent aux exigences en matière d’inclusivité, de fiabilité, d’équité, de reddition de comptes, de transparence, de protection de la vie privée et de sécurité.

L’exploitation éthique des technologies est impossible sans la promotion d’une culture organisationnelle accordant autant d’importance à l’intégrité qu’à la génération de profits. Par exemple, le groupe Volkswagen soutient que, d’un point de vue stratégique et opérationnel, l’intégrité et la conformité sont tout aussi prioritaires que les revenus tirés des ventes, les profits, la qualité des produits et la capacité d’attraction en tant qu’employeur11.

Selon une étude réalisée par IBM, le coût moyen lié aux violations de données a augmenté en 2023, s’élevant à près de 4,5 M$ US12. Le montant des sanctions réglementaires a également augmenté, la société Meta ayant dû payer 1,2 milliard d’euros en pénalités après avoir enfreint le RGPD13.

Les entreprises qui aspirent à se doter d’une stratégie d’exploitation éthique et durable des technologies et des données peuvent adapter des mesures ayant déjà été appliquées dans le cadre d’autres initiatives de durabilité, notamment des mesures axées sur la protection de l’environnement et la bonne gouvernance. L’établissement de cibles et de budgets, l’évaluation de la performance et la publication de rapports sur les progrès réalisés figurent au nombre de ces mesures. La mise en œuvre d’excellentes initiatives de durabilité peut contribuer grandement à répondre aux préoccupations des parties prenantes, permettant même d’attirer des demandeurs d’emploi.

D’ores et déjà, certaines activités de promotion de la durabilité, dont les mesures de lutte contre les changements climatiques, font partie des obligations d’information prescrites par les autorités de réglementation pour les sociétés ouvertes, qui ne peuvent plus se limiter à prendre des engagements sur une base volontaire14. Là où ce n’est pas déjà le cas, les stratégies et principes organisationnels visant l’exploitation éthique des technologies devraient se voir accorder le même niveau d’importance que celui qui est attribué aux programmes de durabilité.

Le renforcement de la confiance dans l’IA, grâce à l’application d’une approche efficace en matière de gouvernance, fait partie des cinq initiatives stratégiques que les équipes d’EY recommandent aux entreprises, de sorte qu’elles puissent maximiser le potentiel de l’IA, tout en surmontant les défis qui s’y rattachent. Voici les composantes de cette approche :

- Mise en place d’un conseil ou d’un comité responsable de l’IA, de même que des principes éthiques définissant les orientations en matière de politiques et de procédures

- Suivi de toutes les dispositions réglementaires pertinentes en vigueur et adoption de mesures visant à assurer la conformité de tous les nouveaux cas d’utilisation

- Définition des contrôles permettant de répondre aux risques émergents

- Préparation en vue de l’entrée en vigueur des mesures législatives prévues

Les leaders qui entendent privilégier l’exploitation éthique de l’IA et des autres technologies émergentes doivent veiller à ne pas tomber dans le piège de prendre des engagements en la matière auxquels ils pourraient ne pas donner suite. Ce piège a été clairement évoqué dans le sondage mondial sur l’intégrité qu’EY a réalisé en 2022 et dont il ressort que 58 % des administrateurs seraient très ou passablement inquiets si leurs décisions devaient être rendues publiques, tandis que 42 % ont signalé que leur entreprise serait disposée à tolérer des comportements contraires à l’éthique de la part de hauts dirigeants ou de cadres supérieurs affichant un bon rendement.

Nouvelles possibilités et nouveaux risques associés à l’essor de l’IA générative

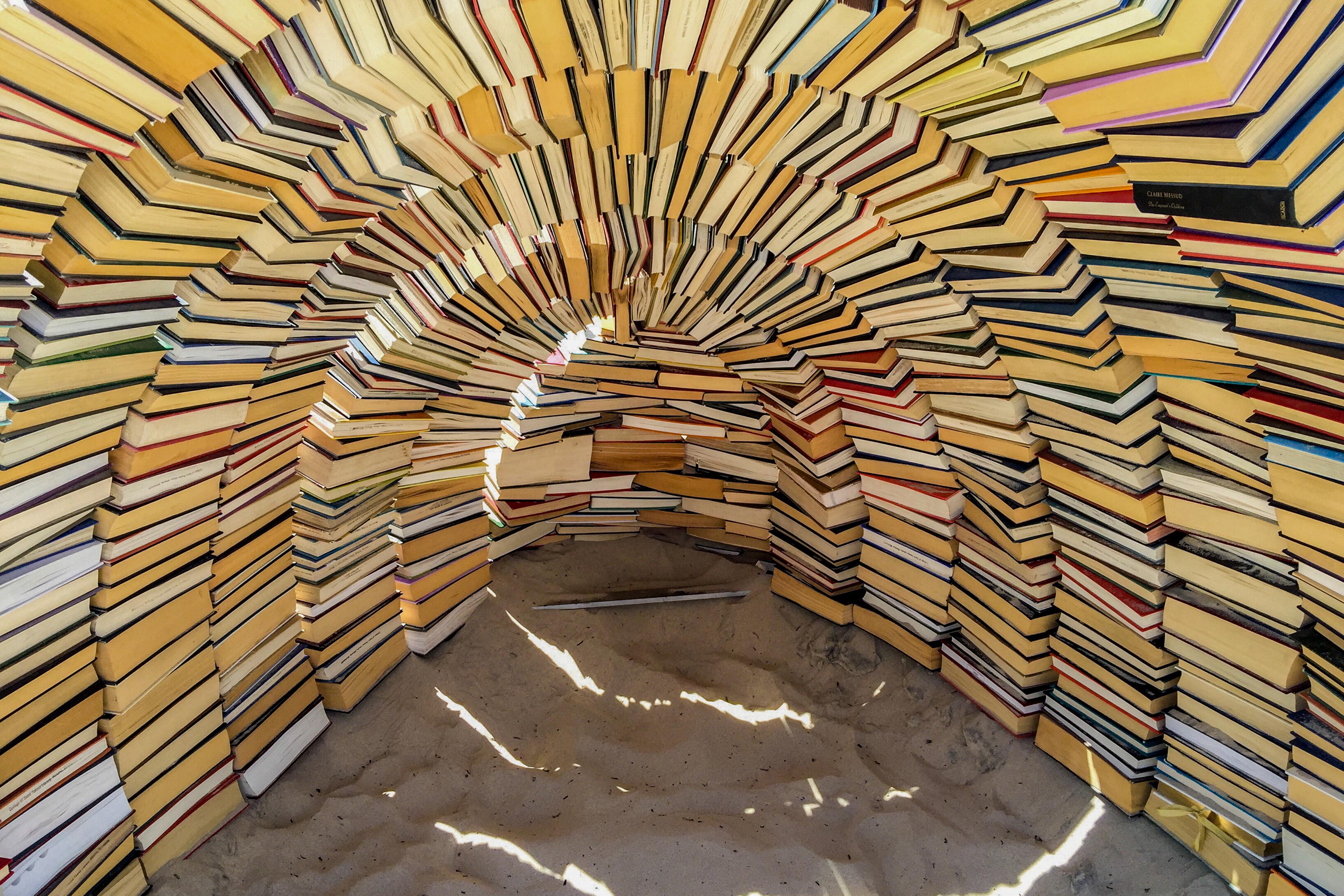

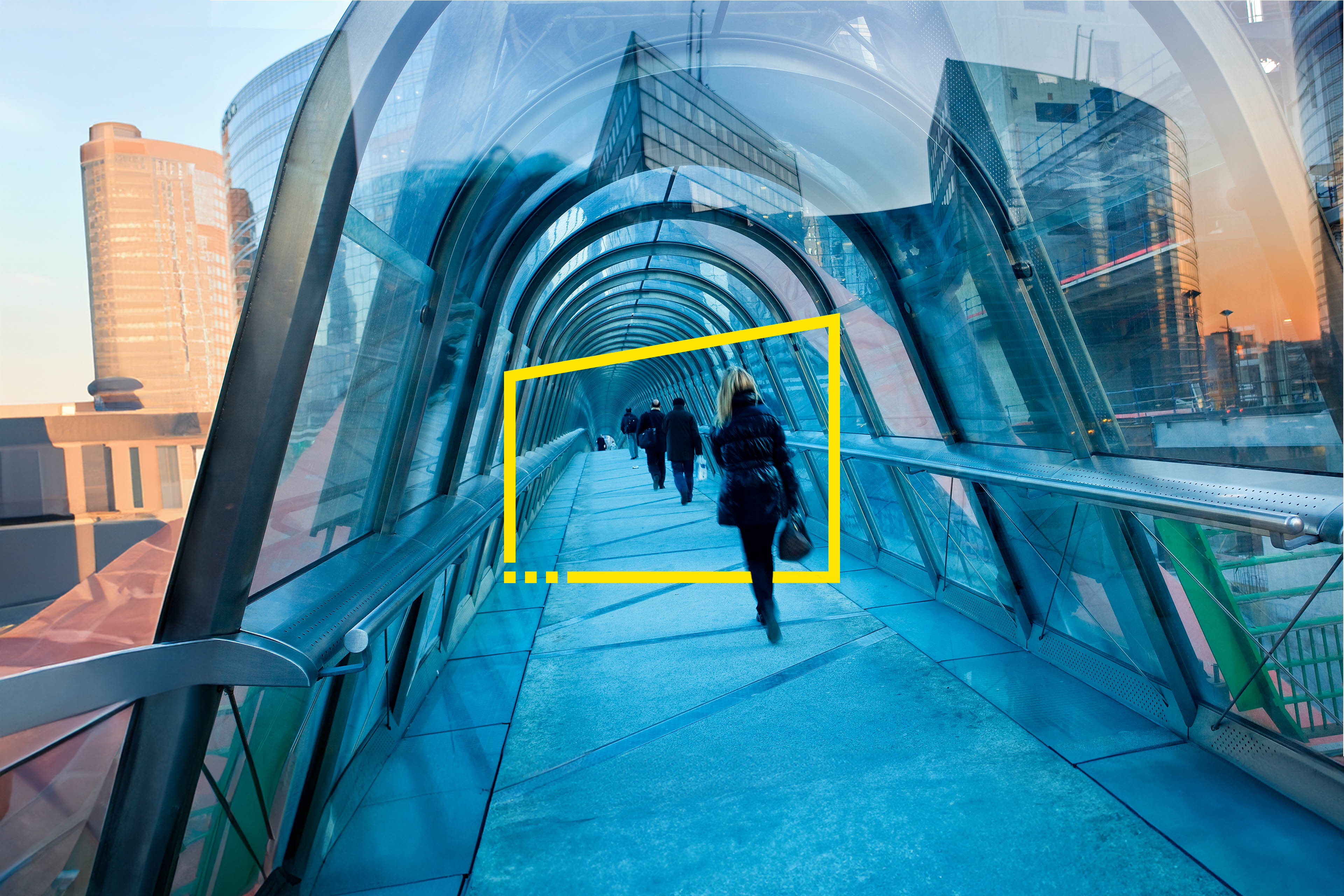

Imaginez que vous avez devant vous deux portes sur lesquelles figure un écriteau différent : « Possibilité technologique » et « Risque technologique ». Quelle porte allez‑vous ouvrir d’abord? Qu’est‑ce qui compte le plus pour votre entreprise? Qu’est‑ce qui entrave votre parcours et qui ralentit votre progression?

L’IA générative rend plus difficile que jamais l’obtention d’un équilibre entre les possibilités et les risques dans la mise en œuvre d’une technologie. Son adoption généralisée en 2023 a eu pour effet d’accroître le niveau de sensibilisation au potentiel associé à tous les types d’IA, de même qu’aux lacunes qui s’y rattachent. Le public veut savoir comment il est possible d’empêcher que l’IA génère de fausses informations et des résultats tendancieux et qu’elle entraîne la suppression d’emplois.

Les grands modèles de langage, tels que ChatGPT, sont en voie de changer la donne pour les fonctions contentieux et conformité, du fait qu’ils permettent d’analyser et de synthétiser d’énormes quantités de documents. Toutefois, les professionnels hautement compétents en gestion des risques d’atteinte à la vie privée et des cyberrisques pourraient bien avoir du mal à évaluer les nouvelles menaces associées à l’exploitation de l’IA. Des avocats ont déjà fait état de causes inventées par l’IA, ce qui explique pourquoi les extrants générés doivent absolument être validés par d’autres outils intelligents et/ou par des êtres humains.

Les entreprises qui cherchent à réduire les risques liés à l’IA générative en en interdisant l’utilisation pourraient voir cette stratégie se retourner contre elles. Plus du quart des employés ayant répondu à un sondage en ligne Reuters‑Ipsos en 2023 ont affirmé utiliser régulièrement l’application ChatGPT d’OpenAI au travail, même si seulement 22 % d’entre eux sont au service d’un employeur qui en autorise explicitement l’utilisation15. Comme les entreprises qui imposent à leurs employés de n’utiliser que des solutions d’IA générative qu’elles approuvent, cela peut favoriser l’adoption de solutions de contournement. Elles doivent absolument se doter de politiques, de normes et de procédures à cet égard, quelles que soient les modalités d’accès à l’IA appliquées à l’échelle organisationnelle.

Même les entreprises qui autorisent l’utilisation de l’IA générative peuvent ne pas avoir une vue d’ensemble des modalités de son déploiement et des risques qui s’y rattachent. Une étude réalisée par le Massachussetts Institute of Technology (MIT) révèle que plus de la moitié des ratés de l’IA sont attribuables à des outils d’IA qui sont factices ou qui proviennent de tiers, de tels outils étant utilisés par 78 % des entreprises à l’échelle mondiale16.

Les entreprises qui souhaitent investir dans l’IA générative doivent se concentrer sur les problèmes qu’elles aspirent à régler et sur le rôle que les données sont appelées à jouer pour elles. L’entreprise dispose‑t‑elle des données nécessaires? Sait‑elle comment les données à sa disposition ont été générées, en connaît‑elle les limites et comprend‑elle ce qu’elles représentent? S’agit‑il de données pouvant servir à la mise au point de grands modèles de langage? L’absence d’un cadre de gouvernance des données adéquat peut engendrer une foule de risques, allant de la génération de résultats tendancieux à la perpétration de violations de données. Même dans les entreprises qui agissent selon les règles de l’art, il y a souvent une rupture dans la communication des mesures à prendre sous une forme que les dirigeants, les investisseurs, les employés et les autres parties prenantes peuvent comprendre.

En réalité, peu importe la porte que vous décidiez d’ouvrir d’abord, elle donne sur la même pièce. Les technologies émergentes qui sont susceptibles de modifier les règles du jeu seront toujours étroitement liées à une multitude de risques juridiques et de risques d’atteinte à la réputation auxquels il faudra répondre de façon stratégique.