Die internationale EY-Organisation besteht aus den Mitgliedsunternehmen von Ernst & Young Global Limited (EYG). Jedes EYG-Mitgliedsunternehmen ist rechtlich selbstständig und unabhängig und haftet nicht für das Handeln und Unterlassen der jeweils anderen Mitgliedsunternehmen. Ernst & Young Global Limited ist eine Gesellschaft mit beschränkter Haftung nach englischem Recht und erbringt keine Leistungen für Mandanten.

So unterstützen wir Sie

-

Wenn die Durchsetzung von Vorschriften und die öffentliche Intoleranz gegenüber einem Fehlverhalten des Unternehmens zunehmen, helfen Ihnen EY-Professionals, Ihre Integritäts- und Compliance-Rahmenwerke zu stärken. Und wenn Verstöße auftreten, etwa Betrug oder Korruption, helfen Ihnen die EY Forensics-Teams, schnell zu reagieren, um Ihr Unternehmen zu schützen.

Mehr erfahren

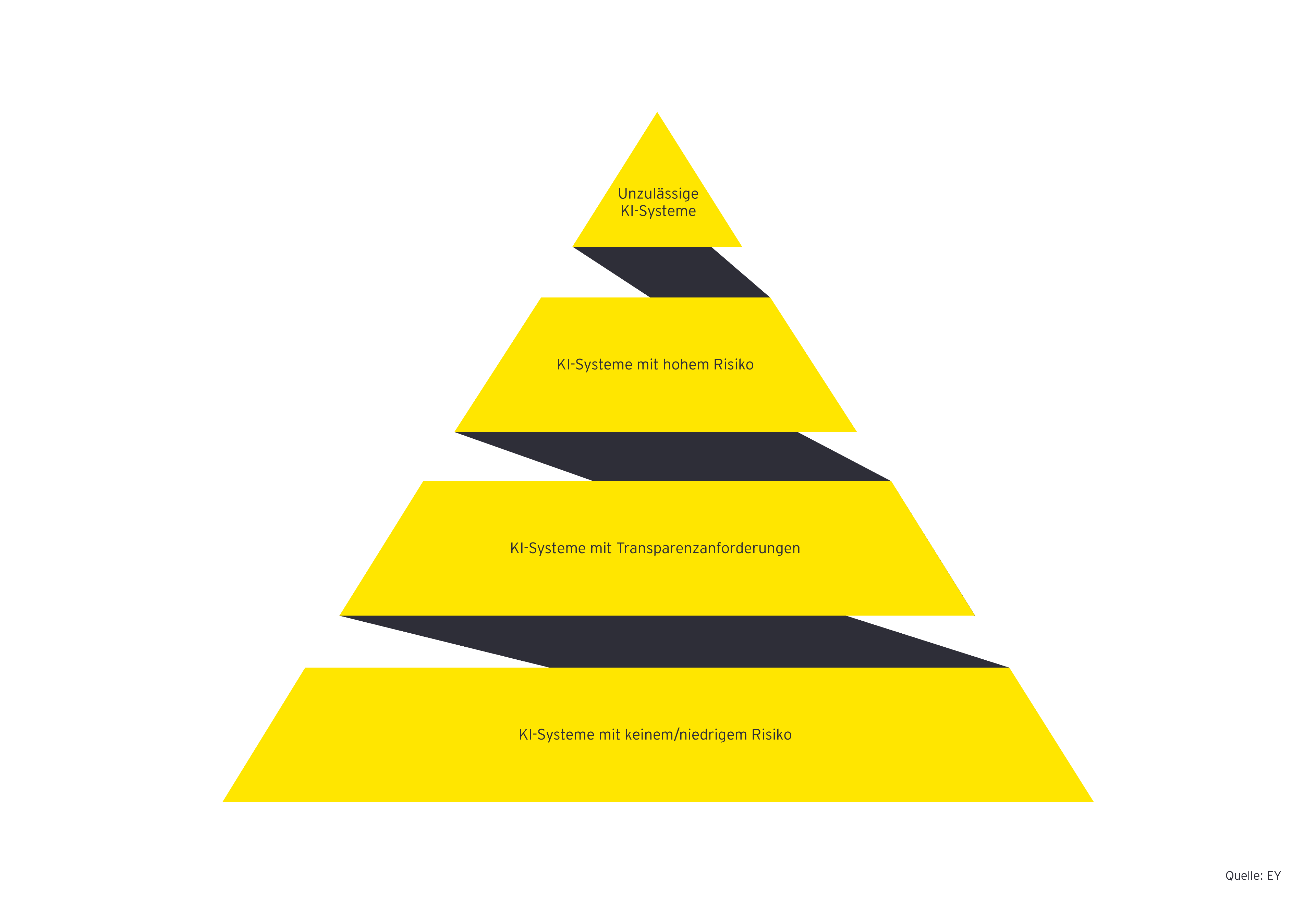

Für den Alltag der meisten Unternehmen sind voraussichtlich nur die folgenden drei der im AI Act aufgeführten Risikokategorien relevant:

KI-Systeme mit hohem Risiko sind solche, die Risiken für Gesundheit, Sicherheit oder Grundrechte von Menschen darstellen. Welche Einsatzgebiete und konkreten Anwendungszwecke dies genau umfasst, wird im Anhang des Gesetzes aufgelistet und nach Inkrafttreten laufend aktualisiert werden. Momentan umfasst diese Liste unter anderem Beschäftigung, Personalmanagement und Zugang zu selbstständiger Tätigkeit (zum Beispiel zur Auswahl von Bewerber:innen, zur Entscheidung hinsichtlich Beförderungen oder zur Kontrolle von Leistung und Verhalten von Arbeitnehmer:innen), Management und Betrieb kritischer Infrastruktur (zum Beispiel zur Steuerung von Stromnetzen oder des Schienenverkehrs) sowie Strafverfolgung, Rechtspflege, Migration und Asyl (zum Beispiel zur Vereinfachung von Entscheidungen). Auch die biometrische Überwachung von Personen fällt in diese Kategorie. All diese Arten fallen unter die Regelungen, die ab August 2026 in Kraft treten. Weiterhin ist ein hohes Risiko gegeben, wenn ein KI-System unter eine harmonisierte europäische Norm fällt, für die eine Konformitätsbewertung (d. h. eine Bewertung und Bestätigung/Zertifizierung) vorgesehen ist. Aufgeführt werden hier unter anderem Normen für Maschinen, Medizinprodukte, Spielzeug oder Aufzüge. Diese Systeme fallen unter die Regelungen, die ab August 2027 in Kraft treten.

Die im AI Act formulierten Anforderungen an die genannten Hochrisikosysteme sind umfangreich und unterscheiden sich je nachdem welche Rolle das jeweilige Unternehmen in Bezug auf KI-System einnimmt - also ob es Anbieter, Importeur, Vertreiber oder Betreiber des Systems ist. Wesentliche Bestandteile sind beispielsweise:

- Risikomanagement

Es muss ein Risikomanagement zum Zweck der Identifikation, Bewertung und Reduzierung von Risiken aufgebaut und auf die KI-Systeme angewendet werden.

- Datenqualität

Es werden bestimmte Anforderungen an die für Training, Testen und Validierung eingesetzten Daten gestellt. Beispielsweise müssen diese Daten relevant, repräsentativ, frei von Fehlern und vollständig sein.

- Dokumentation

Es müssen eine automatisierte Protokollierung des Betriebs und eine umfassende technische Dokumentation gegeben sein.

- Transparenz- und Informationsanforderungen

Gegenüber den Nutzer:innen gelten bestimmte Anforderungen zur Transparenz und Information. Diese sind im Anhang zum AI Act näher definiert. Außerdem müssen eine menschliche Aufsicht und der Eingriff in das KI-System möglich sein.

- Technische Anforderungen

Bestimmte Anforderungen bezüglich der Informationssicherheit müssen gegeben sein. Genauigkeit und Robustheit müssen einem angemessenen Maß entsprechen. Auch hier werden die genauen Anforderungen im Anhang des AI Act näher definiert.

Die Einhaltung der Anforderungen muss durch das Unternehmen sichergestellt werden. Es ist dafür verantwortlich, die Einhaltung der Anforderungen zu bewerten und die KI zu überwachen. Weiterhin müssen KI-Systeme mit hohem Risiko in eine EU-Datenbank eingetragen werden. Auch nach der Inbetriebnahme bleibt es die Aufgabe des Unternehmens, die KI-Systeme zu überwachen und Vorfälle an die zuständigen Stellen zu melden.

KI-Systeme mit Transparenzanforderungen sind solche, die mit Menschen interagieren, Emotionserkennung oder biometrische Kategorisierung betreiben oder künstliche Inhalte generieren, die realen Personen, Orten oder Gegenständen ähneln (sogenannte Deep Fakes). Diese Inhalte müssen auf eine bestimmte Weise gekennzeichnet sein, sodass die Nutzung der KI klar ersichtlich ist und die Erzeugung illegaler Inhalte verhindert wird. Diese Anforderungen gelten ebenfalls ab August 2026.

KI-Systeme mit niedrigem Risiko sind solche, die voraussichtlich kein Risiko für die Nutzer:innen oder deren Daten bedeuten, beispielsweise zu Testzwecken in sogenannten Sandboxes eingesetzte KI-Lösungen. Für sie gelten Anforderungen im Bereich der allgemeinen Produktsicherheit. Es wird auch die freiwillige Erstellung von Verhaltenskodizes empfohlen, die sich an den Vorgaben für KI-Systeme mit hohem Risiko orientieren, jedoch auch weiter gehen können. Auch dies gilt ab August 2026.

Anhand dieser Auswahl wird deutlich, dass eine Klassifizierung in die einzelnen Risikokategorien nur systematisch möglich ist. Besonders für Hochrisikosysteme gelten strikte Anforderungen und Dokumentationspflichten, die eine strukturierte Erhebung und Dokumentierung erfordern.

Neben diesen Systemen gelten besondere Anforderungen für sogenannte General Purpuse AI (GPAI) ab August 2025. Hierunter fallen KI-Modelle, die anhand großer Datenmengen durch „self-supervised learning“ nicht nur für einen speziellen Zweck trainiert wurden, sondern für eine Vielzahl verschiedener Zwecke eingesetzt werden können. Hierzu gehören beispielsweise sogenannte „large language models“ wie GPT-3 und GPT-4 von OpenAI, die unter anderem in ChatGPT zum Einsatz kommen, oder Modelle wie Deepseek, Gemini oder Grok, aber auch KI-Modelle wie DALL-E.

Für solche Modelle gelten zusätzliche Anforderungen, welche sich im EU AI Act, aber auch im EU GPAI Code of Practice, welcher am 10. Juli 2025 veröffentlicht wurde, finden.