Die internationale EY-Organisation besteht aus den Mitgliedsunternehmen von Ernst & Young Global Limited (EYG). Jedes EYG-Mitgliedsunternehmen ist rechtlich selbstständig und unabhängig und haftet nicht für das Handeln und Unterlassen der jeweils anderen Mitgliedsunternehmen. Ernst & Young Global Limited ist eine Gesellschaft mit beschränkter Haftung nach englischem Recht und erbringt keine Leistungen für Mandanten.

So unterstützen wir Sie

-

Bei der Einführung künstlicher Intelligenz (KI) und intelligenter Automatisierung stellen wir den Menschen in den Mittelpunkt.

Mehr erfahren

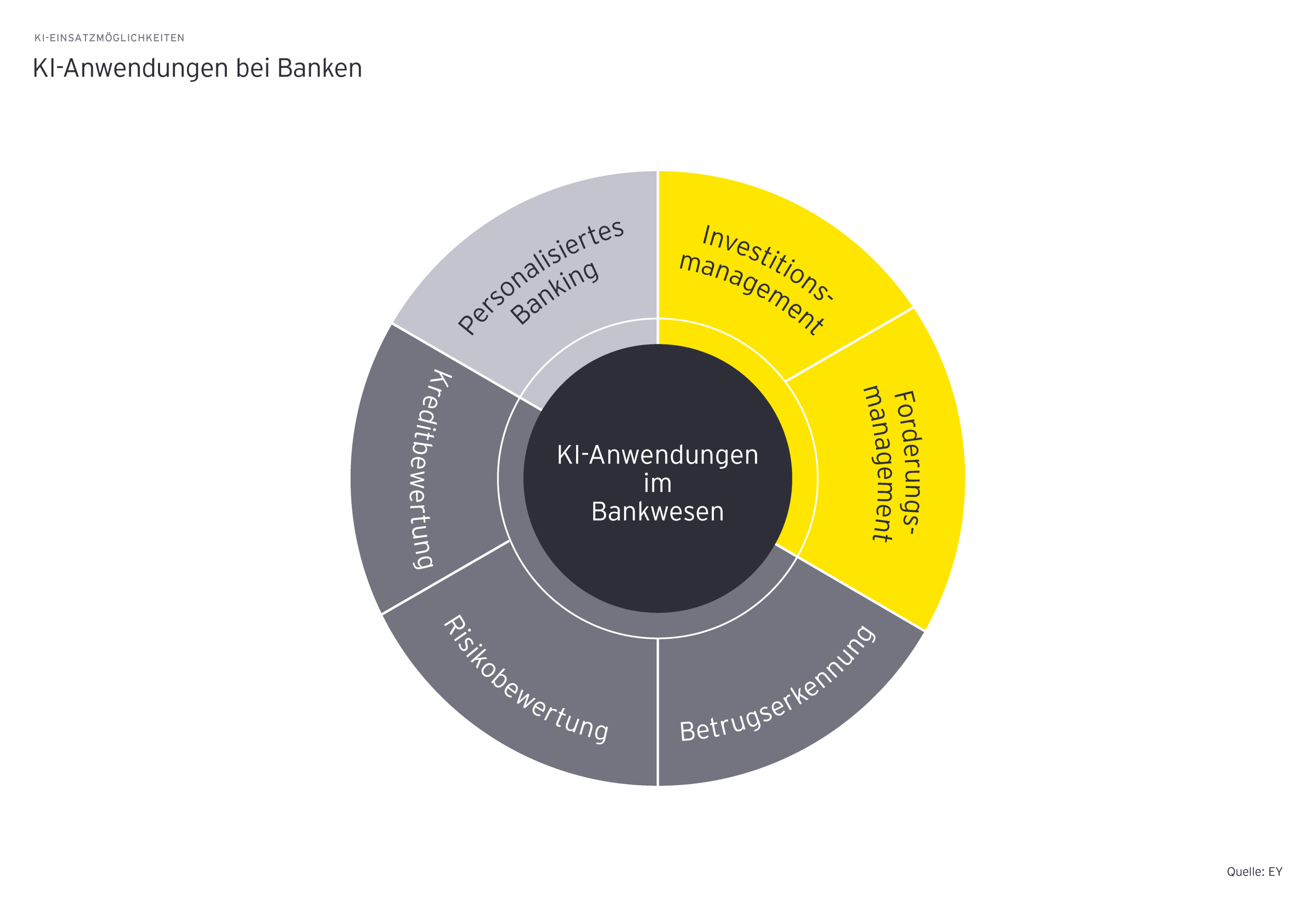

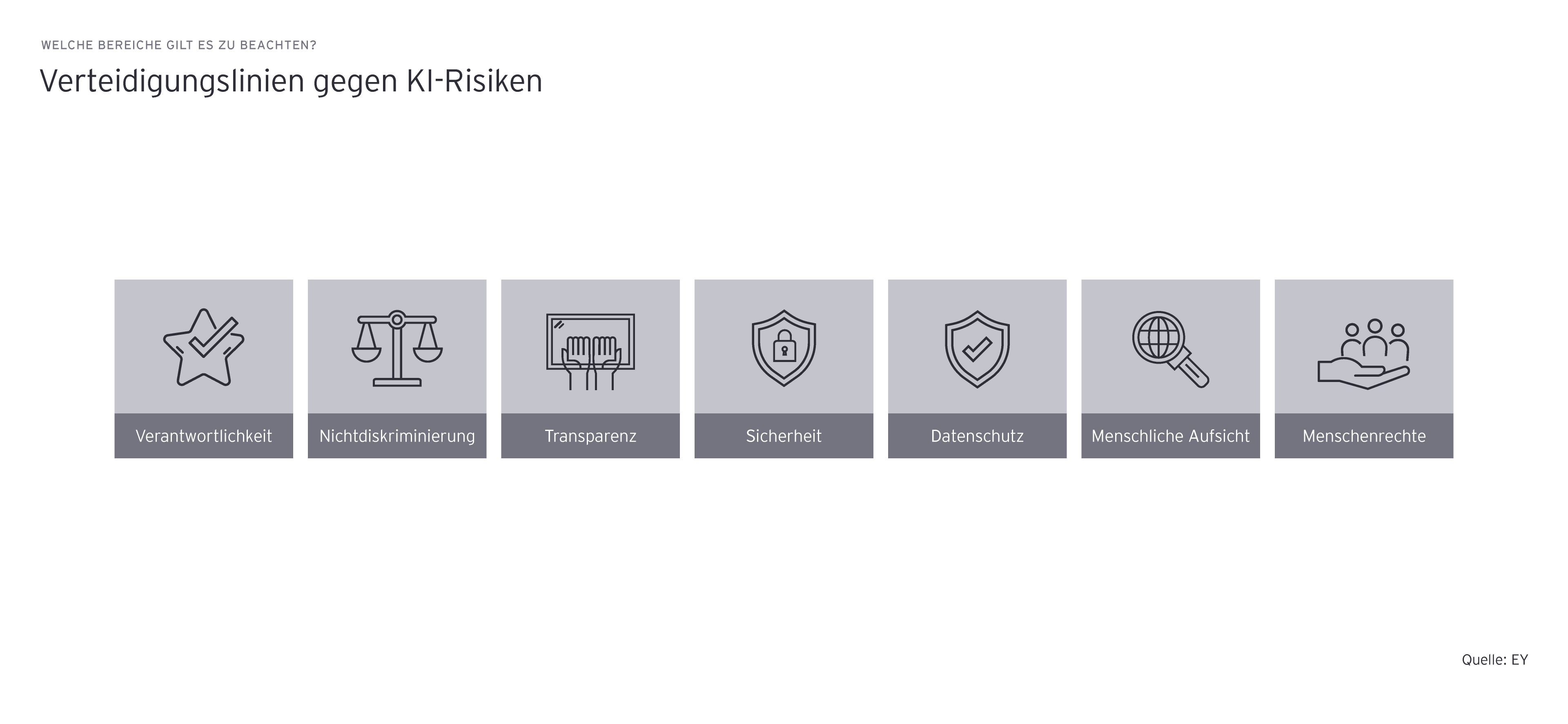

Technologisch gesehen wird von den KI-Lösungen erwartet, dass sie nicht nur genau genug sind, sondern auch fair gegenüber Bevölkerungsminderheiten. Unfairness ist ein häufiges Risiko, das aus unbedachten Entwicklungsplänen für KI-Lösungen resultiert. Man stelle sich ein unfaires Empfehlungssystem für die Kreditvergabe vor, das speziell für eine Gruppe von Personen entwickelt wurde. Ein solches KI-Produkt würde Kunden, die nicht zu dieser Gruppe gehören, falsche Empfehlungen aussprechen.

Die KI-Lösungen sollen robust gegenüber unvorhergesehenen Situationen sein. KI-basierte Investitionsmanagementsysteme sind beispielsweise anfällig für Fehlfunktionen bei unvorhersehbaren Ereignissen wie einer Pandemie. Viele Entscheidungsträger empfinden die mangelnde Transparenz von KI-Lösungen als Showstopper. Komplizierten mathematischen Algorithmen, die nicht leicht zu verstehen sind, zu vertrauen, ist ebenfalls schwer.

Wie jede andere digitale Technologie kann auch eine KI zum Ziel von Cyberangriffen werden. Gezielte Angriffe und eine absichtliche Datenvergiftung sind daher weitere Sicherheitsrisiken, die berücksichtigt werden müssen.