EY oznacza globalną organizację i może odnosić się do jednej lub więcej firm członkowskich Ernst & Young Global Limited, z których każda stanowi odrębny podmiot prawny. Ernst & Young Global Limited, brytyjska spółka z ograniczoną odpowiedzialnością, nie świadczy usług na rzecz klientów.

W skrócie:

- Czy GenAI przyniesie przełom technologiczny w sektorze ubezpieczeniowym? Czy są obszary w zakładzie ubezpieczeń, w których wykorzystanie sztucznej inteligencji niesie za sobą wyjątkowo duży potencjał? Jakie są perspektywy regulacyjne dot. sztucznej inteligencji?

- Jaka jest odpowiedzialność firm ubezpieczeniowych wobec społeczeństwa? W jaki sposób uczezpieczyciele mogą przycznić się do budowania społecznej odpowiedzialności?

- Jak zmieniające się potrzeby i zachowania klientów wpływają na ubezpieczenia? Jak odpowiedzieć na te zmiany?

Rynek ubezpieczeniowy podlega od kilku lat dynamicznym zmianom. Czynników, które mają znaczący wpływ na działalność ubezpieczycieli, jest wyjątkowo dużo: od postępu czy wręcz rewolucji technologicznej, przez rosnącą zwiększoną presję regulacyjną, po zmieniającą się mapę ryzyk i oczekiwań klientów. Nie możemy też zapominać o turbulencjach makroekonomicznych i geopolitycznych. Z pewnością nie należy spodziewać się w najbliższym czasie, że tempo zmian rynkowych spadnie.

Rosnąca niepewność i dynamika zmian stwarza oczywiście wiele wyzwań i problemów, ale jednocześnie otwiera wachlarz nowych możliwości, w szczególności dla branży ubezpieczeniowej. Raport EY „Global Insurance Outlook 2024” wskazuje na trzy istotne obszary rozwoju sektora ubezpieczeniowego: wykorzystanie sztucznej inteligencji (AI), możliwości budowania społecznej odpowiedzialności oraz potrzebę innowacji produktowej – wykorzystania odpowiedzi na zmieniające się potrzeby i zachowania klientów.

Newsletter Sustainability Flash

Wszystkie niezbędne informacje z zakresu Sustainability i ESG w zasięgu ręki.

1. Przełom technologiczny zwiazany z GEN AI

Integracja sztucznej inteligencji z biznesem

Wiele nowych rozwiązań technologicznych miało w ostatnim czasie znaczący wpływ na biznes i społeczeństwo, ale z pewnością żadne z nich nie może się równać potencjałem i poziomem zainteresowania z rozpowszechnieniem modeli generatywnej sztucznej inteligencji. Technologia ta daje ogromne możliwości, jest powszechnie dostępna i w krótkim czasie pojawiły się setki opartych o nią rozwiązań, aplikacji, mających zastosowania w wielu procesach biznesowych praktycznie w każdej gałęzi biznesu. Głównym zadaniem na najbliższy czas dla sektora ubezpieczeniowego jest zbieranie, analizowanie i opracowywanie tych pomysłów oraz przygotowanie bezpiecznych sposobów ich testowania i zaplanowanie odpowiedzialnego wdrożenia.

Źródło: EY CEO Outlook Pulse; lipiec 2023 r.

Gdzie wykorzystać AI?

W ocenie EY największą wartość dodaną dla zakładu ubezpieczeń przyniesie wykorzystanie sztucznej inteligencji w następujących obszarach:

- Aktuarialna wycena ryzyka i underwriting: Usprawnienie pozyskiwania i integracji danych, aby skupić się na pracy o wysokiej wartości – lepsza selekcja ryzyka i automatyzacja procesu taryfikacji, poprawa rentowności, wsparcie analizy rynkowej konkurencyjnych produktów.

- Likwidacja szkód: Automatyzacja procesów obsługi pierwszego zgłoszenia szkody i usprawnienie działań związanych z wykrywaniem oszustw ubezpieczeniowych.

- IT: Poprawa cyberbezpieczeństwa poprzez analizę danych operacyjnych pod kątem prób oszustwa, monitorowanie ataków zewnętrznych i dokumentowanie takich ataków na potrzeby sprawozdawczości regulacyjnej, generowanie kodu w różnych językach programowania oraz dokumentowanie zmian infrastruktury i aktualizacji oprogramowania.

- Marketing i obsługa klienta: Zbieranie opinii klientów, analizowanie wzorców zachowań i przeprowadzanie analizy preferencji, automatyzacja procesu obsługi – dynamiczny rozwój możliwości i zastosowań wirtualnych asystentów.

- Finanse, rachunkowość i ryzyko: Umożliwienie analizy danych finansowych i operacyjnych, a także dokumentów w czasie rzeczywistym, monitorowanie trendów rynkowych i inwestycyjnych.

- Zasoby ludzkie: Wzbogacenie programów oraz materiałów szkoleniowych i rozwojowych dla pracowników, usprawnienie procesu oceny i zarządzania wynikami, wzmocnienie zarządzania wiedzą.

Źródło: EY European Financial Services AI Survey, 2023 r.

Istotne są również zobowiązania prawne i zagrożenia regulacyjne, od potencjalnych naruszeń praw autorskich i własności intelektualnej, przez naruszenia dotyczące wykorzystania danych, po zgodność z ogólnym rozporządzeniem o ochronie danych. Powszechna niepewność co do tego, co jest dozwolone, a co przedsiębiorstwa będą zobowiązane zgłaszać, jest poważnym problemem.

Etyczne wykorzystanie sztucznej inteligencji będzie miało istotny wpływ na zaufanie konsumentów do rynku ubezpieczeniowego. Dla ubezpieczycieli priorytetem musi być ochrona przed wprowadzaniem stronniczości i niesprawiedliwymi wynikami w zakresie pokrycia, cen i decyzji dotyczących roszczeń. Przejrzystość procesów opartych na sztucznej inteligencji – zwłaszcza gdy w grę wchodzą wrażliwe dane klientów – ma zasadnicze znaczenie dla budowania zaufania wśród klientów, partnerów i organów regulacyjnych.

Ubezpieczyciele pozostają dość ostrożni, jeśli chodzi o wdrażanie sztucznej inteligencji w działaniach skierowanych do klientów. Nie jest to niespodzianką, biorąc pod uwagę brak jasności regulacyjnej.

Zrozumienie zagrożeń związanych ze sztuczną inteligencją oraz etyczne jej wykorzystywanie

Sztuczna inteligencja może przynieść znaczne korzyści, od zwiększonej efektywności operacyjnej i obniżonych kosztów, po lepsze doświadczenia klientów i większą inteligencję predykcyjną. Ale ryzyko – w szczególności finansowe, regulacyjne czy reputacyjne – jest tak samo znaczące, jak potencjalne korzyści i ściśle są one ze sobą powiązane. Maksymalizacja zwrotu z inwestycji w sztuczną inteligencję wymaga kompleksowego zrozumienia tych ryzyk, w tym tych, które są unikalne dla poszczególnych firm lub określonych części organizacji. Zagrożenia te obejmują m.in.:

- Dane wrażliwe

- Kwestie związane z przejrzystością

- Tendencyjne i fałszywe wyniki

- Zrównoważoną współpracę między człowiekiem a sztuczną inteligencją

- Obawy dotyczące prywatności

- Niezawodnosc i powtarzalność procesów

- Cyber

Ponieważ wyzwanie jest interdyscyplinarne w danej firmie dyrektor ds. ryzyka (CRO), dyrektor ds. informatyki (CIO) i dyrektor ds. zgodności (CCO) powinni współpracować ze sobą w celu stworzenia ram niezbędnych do realizacji zastosowań sztucznej inteligencji w bezpieczny i kontrolowany sposób w swojej organizacji.

Dobrą praktyką w tym zakresie może być:

- Powołanie komisji etycznej ds. sztucznej inteligencji z doświadczonymi specjalistami, która będzie ustalać zasady etycznego użytkowania i rozstrzygać delikatne spory.

- Zapewnienie, że organizacja posiada kompleksowe ramy zarządzania ryzykiem, zgodne z nowymi wymaganiami, z jasno zdefiniowaną odpowiedzialnością za cały cykl życia sztucznej inteligencji.

- Edukowanie i szkolenie pracowników w zakresie korzyści i zagrożeń związanych ze sztuczną inteligencją w różnych funkcjach i procesach.

- Utrzymywanie kompleksowej bazy danych aplikacji AI w całej firmie, w tym dostarczanych przez zewnętrznych dostawców, która w pełni dokumentuje dane i procesy wykorzystywane do trenowania modeli.

Systematyczne wprowadzanie takich zmian może być trudnym i długotrwałym procesem. Dlatego tak ważne jest, aby działać już dziś. Im szybciej zostanie ustanowione środowisko zarządzania i kontroli, tym szybciej ubezpieczyciele będą w stanie dostosować się do nowych przepisów i – co ważniejsze – zacząć gene rować zwroty z inwestycji w sztuczną inteligencję.

Perspektywy regulacyjne dotyczące sztucznej inteligencji

Organy regulacyjne na całym świecie aktywnie pracują nad wytycznymi i wstępnymi przepisami dotyczącymi wdrażania sztucznej inteligencji. Powszechna dostępność aplikacji GenAI sprawiła, że zadanie stało się pilniejsze. Zakres wdrażanych regulacji może być jednak różny w zależności od miejsca, co będzie przekładało się na praktyki zastosowań AI na lokalnych rynkach. Stany Zjednoczone prawdopodobnie będą powoli przyjmować tylko ograniczone regulacje, podczas gdy europejscy ubezpieczyciele przygotowują się do kompleksowego prawodawstwa w postaci unijnego aktu w sprawie sztucznej inteligencji, co do którego osiągnięto porozumienie polityczne 8 grudnia 2023 r. Firmy technologiczne i inwestorzy venture capital ostrzegają, że kompleksowe regulacje mogą osłabić innowacje i zaszkodzić konkurencyjności. Proponowany przez Komisję Europejską akt w sprawie sztucznej inteligencji opiera się na klasyfikacji systemów sztucznej inteligencji w oparciu o kryterium ryzyka. W ramach tzw. systemów sztucznej inteligencji wysokiego ryzyka ujęte zostały niektóre aspekty działalności ubezpieczeniowej, szczególnie w sektorze ubezpieczeń zdrowia i życia. Nie oznacza to oczywiście, że rozwiązania bazujące na nowych technologiach nie będą mogły być z sukcesem wdrażane w branży. Konieczne będzie jednak zapewnienie zgodności z tymi przepisami, tak aby jednocześnie zapewnić bezpieczeństwo użytkowników oraz umożliwić innowacje i dalszy rozwój sektora.

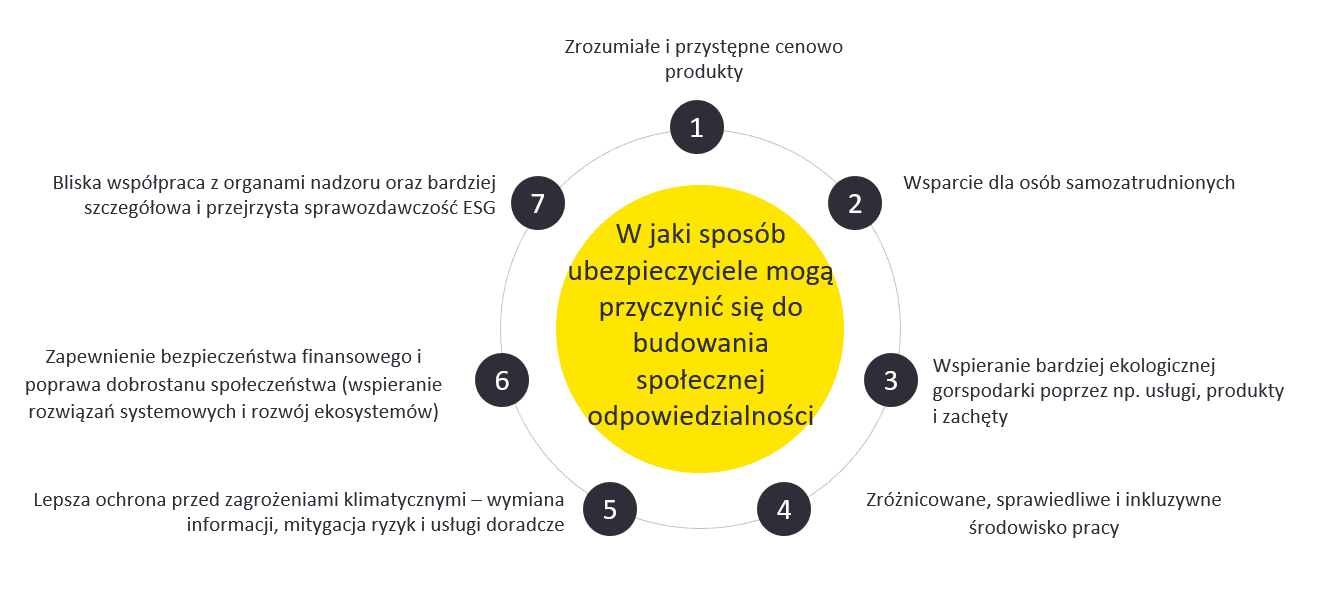

2. Społeczna odpowiedzialność sektora

Od pandemii i klęsk żywiołowych po nierówności ekonomiczne i zmiany demograficzne, wydarzenia ostatnich lat skłoniły więcej osób do zastanowienia się nad społeczną rolą biznesu i odpowiedzialnością, jaką duże firmy mają wobec obywateli i społeczności na całym świecie. Pojawienie się ruchu ESG (Environmental, Social and Governance) podniosło poprzeczkę dla wszystkich rodzajów przedsiębiorstw, które muszą podejmować celowe zobowiązania, zdecydować się na znaczące działania w celu ich realizacji i raportować swoje wyniki.

Konsumenci i inwestorzy są coraz bardziej zgodni co do tego, że ubezpieczyciele mogą i muszą dostarczać wartość społeczną. Ubezpieczyciele znajdują się w centrum uwagi ze względu na swoją głęboką wiedzę na temat ryzyka i wyjątkową zdolność do ochrony ludzi, rodzin i firm o różnych kształtach i rozmiarach.

BUDOWANIE SPOŁECZNEJ ODPOWIEDZIALNOŚCI

Źródło: Raport EY Global Insurance Outlook 2024.

Zmniejszanie luk w ochronie i oszczędnościach

Od dłuższego czasu istotnym tematem dla sektora jest luka ubezpieczeniowa, zarówno w obszarze nowych ryzyk, jak i adekwatności sum ubezpieczenia. Priorytetem na najbliższy czas powinno być przygotowanie odpowiedzi rynku oraz wykorzystanie potencjału stojącego za tym wyzwaniem. Niedobory w obszarze zabezpieczenia emerytalnego, rosnąca liczba osób pracujących według nowych form zatrudnienia i brak odpowiedniej oferty ubezpieczeniowej dla tego segmentu klienta oraz budowanie świadomości i oferty produktowej dla zagrożeń cybernetycznych – to tematy, które niosą za sobą potencjał wzrostu rynku. W wielu obszarach luki te stały się zbyt duże, aby jedna grupa lub podmiot mogły je samodzielnie pokryć. Publicznoprywatne programy podziału ryzyka mogą łączyć zdolności ubezpieczeniowe reasekuratorów z działaniami na rzecz ograniczenia ryzyka.

Drugi segment ryzyk, w którym luka ubezpieczeniowa powiększa się w ostatnich latach, to ryzyka klimatyczne. Wartość luki rośnie z uwagi na wzrost częstotliwości i dotkliwości powodzi, mrozów, fal upałów, susz i pożarów oraz innych katastrof naturalnych. Z uwagi na długofalowość tego trendu, niezbędne są działania ograniczające. Pierwszym czynnikiem istotnym w tym zakresie jest coraz lepsza predykcja ryzyk klimatycznych. Kilku europej-skich ubezpieczycieli wykorzystuje nowe strumienie danych (np. satelity, drony, czujniki naziemne), aby stworzyć nowe możliwości ostrzegania przed suszami, trzęsieniami ziemi i osunięciami ziemi. Zmienne modele cenowe i programy świadomości ryzyka mogą również stworzyć zachęty dla klientów do zmniejszenia ich ekspozycji. Drugim czynnikiem są działania prewencyjne powodujące zmniejszenie częstości oraz skutków zdarzeń. Z uwagi na ogromne koszty stojące za wdrożeniem takich działań, kluczową rolę ma do odegrania tutaj sektor publiczny.

Przejście na bardziej ekologiczną gospodarkę to kolejny obszar, w którym branża może odgrywać wiodącą rolę. Ubezpieczyciele majątkowi mogą bezpośrednio wpływać na zachowania konsumentów poprzez cechy produktów i zachęty. Z drugiej strony ubezpieczyciele na życie, jako duzi inwestorzy instytucjonalni, mogą wspierać rozwój zielonej infrastruktury i promować przyjazne dla środowiska opcje inwestycyjne dla klientów dbających: zrównoważony rozwój. Wszystkie te kroki jednocześnie przynoszą wartość indywidualnym klientom i całemu społeczeństwu.

Ulepszone propozycje wartości dla pracowników, które przynoszą korzyści wszystkim

Ponieważ ubezpieczyciele nadal mają trudności ze znalezieniem talentów, których potrzebują, celowe zaangażowanie się w wartość społeczną może być potężnym narzędziem przyciągania i zatrzymywania talentów. Jest to szczególnie ważne teraz, gdy poko lenie Z i pokolenie Milenium stanowią dużą część siły roboczej.

ODSETEK LUDNOŚCI NA ŚWIECIE

Źródło: World Economic Forum, 2023 r.

Ponadto ubezpieczyciele mogą przyczynić się do budowania bardziej inkluzywnego społeczeństwa, wychodząc poza uprzedzenia w budowaniu prawdziwie zróżnicowanej bazy talentów i integracyjnego środowiska pracy. Obejmuje to nie tylko zatrudnianie osób wszystkich ras i grup etnicznych, w każdym wieku, płci i orientacji seksualnej, ale także zatrudnianie osób neuroróżnorodnych.

Opracowywanie strategii i raportowanie wartości społecznej

Cele związane z budowaniem społecznej odpowiedzialności powinny być uwzględniane w ogólnych strategiach rozwoju ubezpieczycieli, a nie jedynie w spełnianiu wymagań regulacyjnych. Raportowanie wskaźników zgodnie z obowiązkowymi i dobrowolnymi standardami wzmacnia zaangażowanie ubezpieczyciela w wypełnianie luk w oszczędnościach emerytalnych i ochronie, zwłaszcza wcześniej niedostatecznie obsługiwanych segmentów klientów czy zmniejszanie emisji dwutlenku węgla. Wskaźniki operacyjne i wydajnościowe mogą uzupełniać inne dane ESG (np. różnorodność pracowników i zarządu). Bardziej szczegółowe informacje wyjaśnią również organom regulacyjnym, inwestorom i konsumentom, że ubezpieczyciele są w pełni zaangażowani w realizację swoich strategii ESG i skutecznie je realizują. Ubezpieczyciele będą potrzebowali jasnej i przekonującej narracji dotyczącej związku między celami rentowności a wpływem społecznym. Rynki kapitałowe będą chciały wiedzieć, że te dwie kwestie nie są ze sobą sprzeczne. Pomocne w tym mogą być nowe standardy raportowania: koncepcja „podwójnej istotności” CSRD wymaga od przedsiębiorstw określenia, w jaki sposób kwestie związane ze zrównoważonym rozwojem mogą stwarzać ryzyko finansowe (istotność finansowa) oraz określać wpływ firmy na ludzi i środowisko (istotność wpływu).

Cele te często wymagają perspektywy długoterminowej, co może utrudniać ubezpieczycielom osiągnięcie krótkoterminowych wyników. Bardzo ważne będzie zachowanie równowagi w tempie i zakresie wdrażanych zmian, by z jednej strony nie narazić się na ryzyko „greenwashingu”, a z drugiej na ryzyko zaniedbania interesów firmy i klientów.

Zdolność do generowania znaczących korzyści dla wszystkich części społeczeństwa powinna być filarem kreowania propozycji wartości branży – zarówno dla klientów, inwestorów, jak i organów regulacyjnych.

3. Zmieniające sie potrzeby i zachowania klientów

Zmieniające się potrzeby klientów powodują, że także sposoby dotarcia do klientów wymagają rozwoju. Ekosystemy i wbudowane ubezpieczenia pojawiły się przede wszystkim dlatego, że zapewniają to, czego oczekują klienci. Ekosystemy zapewniają wygodny, kompleksowy dostęp do szerszego zestawu produktów uzupełniających. Wbudowane ubezpieczenia są atrakcyjne dla konsumentów, którzy chcą zabezpieczyć ważne zakupy i bezproblemowo zintegrować ochronę ze swoim codziennym życiem. Zaufanie i świadomość marki odgrywają kluczową rolę w ekosystemach, ponieważ duża część zysku jest zwykle osiągana przez organizatora. Ubezpieczyciele wchodzący do ekosystemów kierowanych przez innych muszą przyjąć zrównoważony pogląd na korzyści i ryzyko. Dostęp do nowych klientów jest ważny, ale niekorzystna selekcja jest istotnym ryzykiem. Współpracując z dużymi markami, ubezpieczyciele mogą spotkać się z presją, aby zaakceptować całą działalność, co może zagrozić ich kontroli nad ryzykiem wpływającym do ich portfeli.

W Europie adaptacja ubezpieczeń wbudowanych jest wolniejsza niż oczekiwano, głównie ze względu na bardziej rygorystyczne przepisy dotyczące prywatności danych. Europejscy ubezpieczyciele zachowują też ostrożność, jeśli chodzi o narażanie na szwank wartości swojej marki w kanałach prowadzonych przez inne firmy. Chociaż analitycy rynkowi są zgodni co do tego, że wzrost ekosystemów będzie znaczący i trwały, zmiana nie nastąpi z dnia na dzień. Aby segment ten zaczął przynosić znaczącą składkę potrzebne są dobre praktyki dotyczące zarówno standardów współpracy, jak i obsługi klienta oraz technologia i produkty specjalnie sprofilowane pod taki typ współpracy.

Podsumowanie

Ubezpieczyciele muszą być przygotowani na radzenie sobie z wyższymi kosztami, nowymi realiami rynku pracy, niepewnością makroekonomiczną i szerszymi wymogami regulacyjnymi. W tych zawirowaniach pojawiają się jednak wyraźne oznaki przyszłego wzrostu. Przełom technologiczny związany z Gen AI może zrewolucjonizować działalność firm, ale ubezpieczyciele muszą poświęcić czas na ustanowienie wystarczająco solidnych modeli zarządzania i polityk, które zapewnią odpowiedzialne i etyczne korzystanie ze sztucznej inteligencji. Rozwijając swoją społeczną odpowiedzialność, firmy powinny skupić się nie tylko na działaniach przyczyniających się do jej budowy, ale także zadbać ukierunkowanie programów brandingowych, marketingowych i komunikacyjnych wokół celu organizacyjnego związanego z potrzebami ludzkimi i społecznymi. Z kolei rozwój ubezpieczeń wbudowanych daje potencjał na lepsze odpowiedzenie na zmieniające się potrzeby klientów. Jeśli ubezpieczyciele odpowiednio wykorzystają te możliwości, to przekształcą je w wartość dla klientów, społeczeństwa jako całości i własnych wyników finansowych.

Artykuł ukazał się w Tom 21, Numer 1, Styczeń 2024 Miesięcznika Ubezpieczeniowego

Jak EY może pomóc

Skorzystaj ze wsparcia w obszarze jakim jest aktuariat. Oferujemy usługi aktuarialne (doradztwo aktuarialne) i pomagamy podejmować świadome decyzje w dobie transformacji technologicznej i regulacyjnej.

Przeczytaj więcejLider

-

Marcin Sadek

Marcin SadekEY Polska, Lider Doradztwa dla Sektora Ubezpieczenowego, Partner

-

Hanna Ulańska

Hanna UlańskaEY Polska, Risk Consulting, Partner

-

Nasze pragmatyczne podejście biznesowe pomaga klientom reagować na fizyczne ryzyko zmian klimatu, a także działać na nowych rynkach i środowiskach regulacyjnych związanych z emisją dwutlenku węgla i energią odnawialną.

Przeczytaj więcej -

Nasze doradztwo transakcyjne to klucz do sukcesu Twoich transakcji biznesowych. Poznaj nasze innowacyjne podejście i osiągnij lepsze wyniki z EY Polska.

Przeczytaj więcej

Polecane artykuły

Jak odpowiedzieć na nowe wyzwania w obszarze kreowania produktów ubezpieczeniowych?

Sektor ubezpieczeniowy objęty został wpływem nowych i istotnych trendów, które wymuszają także transformację w myśleniu o produk-tach ubezpieczeniowych i sposobie budowania oferty dla klienta.

ESG w zakładach ubezpieczeń – jak przygotować się na nowe wyzwania?

Branża finansowa jako kluczowy inwestor instytucjonalny ma stanowić główny oręż w przekierowaniu kapitału w stronę zrównoważonych inwestycji