EY安永是指 Ernst & Young Global Limited 的全球組織,也可指其中一個或多個成員機構,各成員機構都是獨立的法人個體。Ernst & Young Global Limited 是英國一家擔保有限公司,並不向客戶提供服務。

金融服務業領導峰會彙集了金融服務領域董事會成員、高階主管和利害關係人以及其他相關領域專家。《視點》對峰會中討論的內容進行彙整,旨在解決迫在眉睫的問題、提高金融市場公信力。

概要

- 各國監管原則發展趨勢

- 風險評估合規觀察:AI服務提供商(Vendor)

- 風險評估合規觀察:AI服務使用/應用者

- 金融業AI監管與風險評估發展趨勢觀察

前言

安永關注到現有AI系統評估框架大多借鑑資料保護影響評估(DPIA)1 與隱私影響評估(PIA)2,前者與資料存儲、蒐集與使用相關;後者涉及個人數據蒐集與處理過程的風險評估,兩者皆集中在資訊系統議題,甚少考慮人工智慧對個人、社會和環境的廣泛影響,例如:環境影響評估(EIA)3、道德影響評估(EtIA)4 以及人權影響評估和/或社會經濟影響評估(SEIA)5 。

本文主要整理安永與Trilateral Research 6 研究彙整國際AI監管發展趨勢、對AI服務提供商(Vendor)與AI服務使用/應用者的風險評估與合規標準,以及金融業AI監管與風險評估發展趨勢,期望透過此份研究摘要協助金融機構更加了解國際與國內監管差異,進而更好地管理、評估和應對AI風險管理的監管需求與演變。

下載《安永金融產業文摘 - 2024年1月號》

一、各國監管原則發展趨勢

雖然人工智慧的發展已有歷史,但對於人工智慧的監理規範才逐漸成形。研究歐洲、北美地區與部分亞太地區的監管機構發布的人工智慧監理計畫與監理目標,可以發現監管原則大致上分成兩類:

- 就人工智慧的使用進行評估:著重評估人工智慧使用上可能產生的風險並逐一進行風險評估,如:訓練資料的偏誤、系統的穩健性、資訊安全的防護性等。

- 依據人工智慧系统或應用進行風險分類後進行評估:根據AI應用領域進行不同維度的風險評估如:醫療領域AI應用較消費者推薦系統AI應用風險層度來的高,應適用不同較嚴格且全面的風險評估。

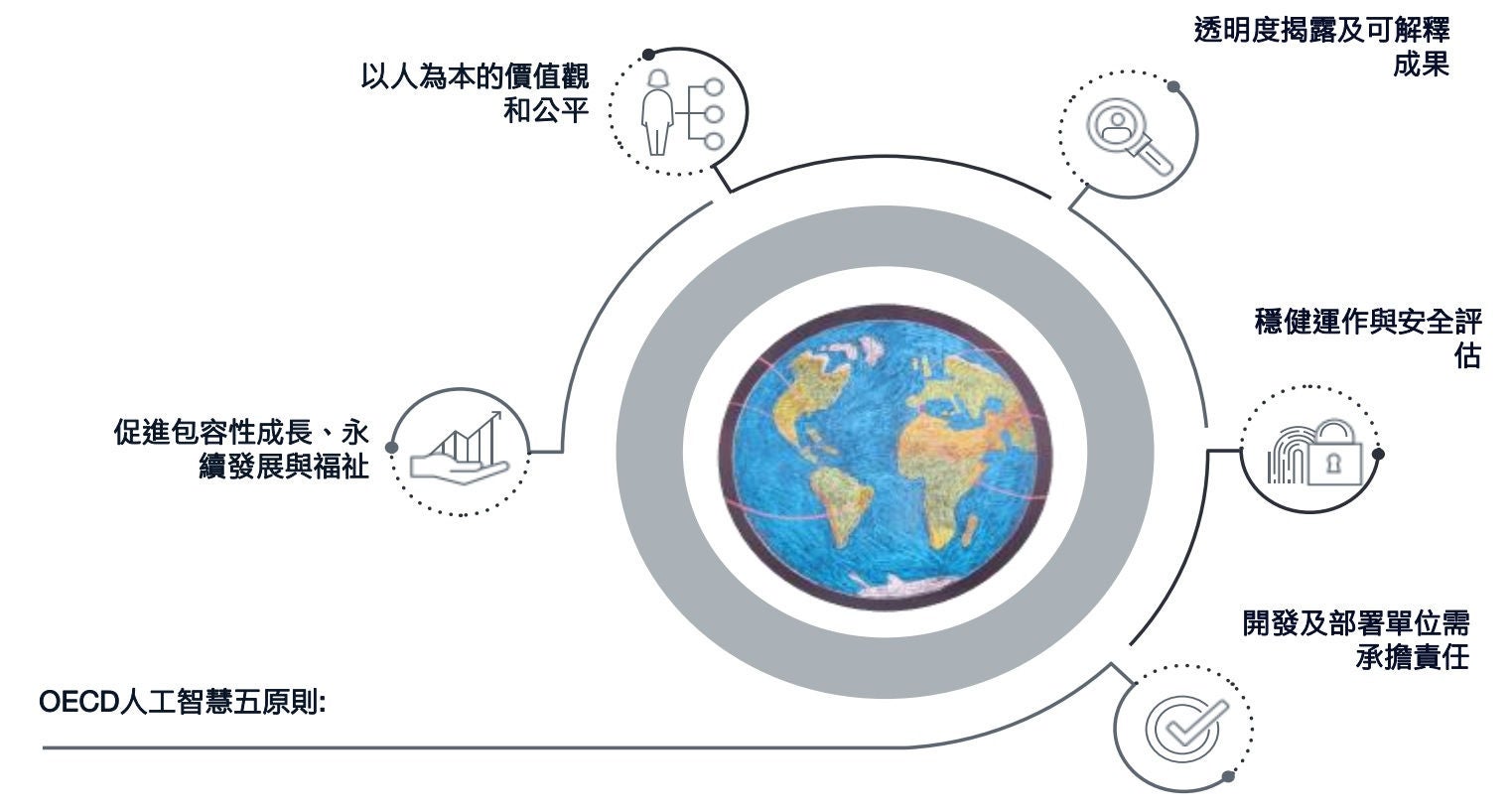

OECD人工智慧發展原則 7

在2021年2月,OECD AI專家提出了一個用於分類AI系統的框架 8,而後各國監管在這個架構下結合風險基礎法發展各自的監理方向。以歐盟委員會AI法案中的風險評估建議為例,其風險評估結果可分為四個等級:

- 不可接受的

- 高風險

- 有限/低風險

- 幾乎無風險

該法案認為企業對於不同層級的風險應該要設定相關的管控措施,特別是對於不可接受的風險(亦即損害可逆性或可復原性幾乎為零者),應設計相關的禁止措施,而對於有風險存在者,應設計風險抵減的手段,以保護使用者與所有利害關係人的權益。

觀察國際AI監管發展,發展相對快的是歐盟,其推出的AI法案,預計明年會正式立法;已有草案成形但尚未有立法時程的國家則有加拿大、美國、中國等國,而提出框架研擬相關草案細節的則有印度等國。我們的研究發現各國監管機關對於AI模型開發的監管共識是其發展需要符合一定程度的道德準則,然而對於AI服務提供商與AI使用者的規範面向則有不同,如:美國對於AI服務提供商的規範相較AI服務使用者之規範較多,AI服務提供商的規範多是對AI服務的本身是否有存在風險,並且對於這些風險是否有設計相對應的管控方式。AI使用者則是偏向在使用AI進行各類產出時,是否存在侵害他人權利的風險。後續章節我們將會分別對AI服務提供商與AI服務使用者的規範跟風險指標進行進一步說明。

二、風險評估合規觀察: AI服務提供商(Vendor)

1. 風險管控與合規標準

自2019年開始,美國參議院提出了演算法問責法案,目標是對於AI服務提供商,提升系統決策的透明性與公平性,該法案亦為我國資策會關注焦點之一。該法案對於AI服務提供商進行監理上的收緊與罰則。觀察監理趨勢,我們認為對於AI服務商而言,可信賴的AI應該至少要包含以下的指標:人工介入與監督、技術穩健性與安全性、隱私防護與資料治理、透明度、多元,無偏見且具公平性、社會與環境友善、問責性。

許多監管機構建議AI服務提供商在系統開發/導入階段就需要設計一套人工智慧風險評估與監控方法,以此確保在服務進入市場前後,任何可能的風險都能被實時監控;若發生任何重大問題,AI服務提供商應該要向相應的監管機關回報。我們認為,開發商及服務提供商面對監管的風險評估要求,可透過以下幾個步驟建構人工智慧風險管理措施:

- 辨識分析已知風險

- 評估可能發生風險

- 在進入市場前的監控階段評估其他可能風險

- 導入合適的風險管理機制與衡量指標

對於欲建構人工風險管理架構的AI服務提供商,我們建議可參考加拿大提出的演算法影響評估工具(AIA),其集結了公私領域的參與者意見,如學術單位、社群或其他公開機構,提出一趟完整的演算法影響自我評估方法,根據風險維度(演算法的使用與固有風險)與管控維度(是否有任何風險抵減措施)進行區分,透過回答線上的問題集可以協助AI服務提供商了解並分析AI系統的風險與目前內部的管控情形。

加拿大演算法開發評估工具

風險維度評估內容 | ||

1. 計畫 | 3. 演算法 | 5. 影響 |

|

|

|

2. 系統 | 4. 決策 | 6. 資料 |

請說明系統的功能與架構。 | 說明適用的輔助判斷決策目標(例如醫療服務、社會服務、認證服務等) | 請說明資料來源、資料結構、蒐集方法與資料安全的措施。 |

管控維度評估內容 | |

1. 諮詢建議 | 2. 降低與緩解風險的措施 |

|

|

下方彙整由標準制定組織所發布的AI風險管理及治理相關標準,建議AI服務提供者可以參酌下列驗證標準將AI風險評估納入現行的風險管理和治理流程中,用以開發一套以風險為基礎考量的可信賴AI商品。

驗證標準 | 簡介 |

ISO/IEC 23894 - Information Technology - Artificial Intelligence - Risk Management | 《資訊科技—人工智慧—風險管理指南》 ISO 23894提供了在開發和應用人工智慧技術和系統過程中管理風險的指南,幫助組織將風險管理整合到與人工智慧相關的活動和職能中。該標準包括三項重點,分別是:

|

IEEE 7000-2021 - IEEE Model Process for Addressing Ethical Concerns During System Design | 《IEEE處理系統設計中道德擔憂的模型流程》 IEEE 7000-2021建立了一套流程,使組織能夠在概念的探索和開發階段即考慮道德價值觀。此標準使利益相關者可以進行管理和工程上對於道德價值觀的優先考慮,並進行透明化的溝通。它描述了在營運概念、道德要求和基於道德風險的設計中,如何追溯道德價值觀的流程。此標準適用於所有大小和類型的組織,並可以使用其組織的生命週期模型。 |

IEEE 7010-2020 - IEEE Recommended Practice for Assessing the Impact of Autonomous and Intelligent Systems on Human Well-Being | 《評估自主智慧系統對人類福祉影響的推薦實踐標準》 IEEE 7010-2020推薦採用福祉為基礎的評估流程,透過對自主智慧系統(A/IS)9 整個生命週期使用福祉影響評估(WIA)10,以促進與保障人類福祉。該推薦標準為不同產業的開發者在A/IS整個生命週期中,提供在各階段應考慮的影響與評估,以確立與A/IS相關的人類福祉概念、改善領域、提供風險緩解策略、評估效能,並辨別預期和非預期用戶的產生、A/IS對人類福祉的用途和影響。 |

2. 風險評估建議

AI開發原則選定可以依據當地監管期望或行業需求進行調整,像是OECD人工智慧五原則、歐盟執委會人工智慧高級專家小組《可信賴的人工智慧倫理準則》、美國《AI權利法案藍圖》等。而針對前述原則衍生的風險管理框架特點則建議包含:

- 廣泛範疇:組織應全面考慮AI對不同道德問題和社經議題的影響;

- 可操作性:組織應能夠將概念原則轉化為可實施的策略,涵蓋AI生命周期的各階段,包括AI系統應用情境發想、系統開發、部署和監控;

- 靈活性:該框架應能適應各種AI系統、使用案例、實施情境和組織環境,確保框架可以根據特定需求和要求進行調整;

- 滾動調整:該框架應貫穿在AI系統的整個生命周期並持續調整;

- 透明:在使用人工智慧時確保相關參與者知曉數據驅動的決策,並有渠道查詢和挑戰這些決策;

- 參與:該框架納入來自各學科專家和可能受到人工智慧系統影響的利益相關者的觀點和意見,確保評估過程中聽取和考慮到多元的聲音。

我們觀察到若要將上述AI原則落地,可透過建構一個有效的AI風險評估方法來符合各國監管期望與認證標準,相關服務提供商可考量以下風險評估要點發展自己的風險評估架構及流程:

- 在企業層面應發展一個迭代的風險評估與管理流程 11,其中包含:

- 內部分析:辨識該AI服務的開發與營運單位;

- AI使用者與利益關係者參與:討論使用該AI服務後可能對人類福祉與社會環境的影響;

- 資料蒐集:與影響評估相關的數據收集和追踪(可能超出與AI服務開發本身相關的數據範圍)。

- 在商品開發單位層面建議風險評估至少應在以下三個階段進行導入 12:

- 該服務的初始設計階段;

- 該服務上市前;

- 該服務上市後;

並邀請相關單位進行反覆討論與檢視。

我們期望透過上述整理幫助AI服務提供商理解和應對AI道德議題和社會影響,從而彌補並落實可信賴AI的治理與管控。

三、風險評估合規觀察:AI服務使用/應用者

1. 風險管控與合規標準

分析各國對於AI監理方向,對於AI服務使用者/應用者而言,可信任AI應該要有以下特性:

- 取代人為決策的必要性

- 具備人工管控的程序與監督流程

- 無偏見且公平的

- 不侵害著作權、隱私權等利害關係人權益

- 使用/應用的透明(使用者需知悉AI系統的功能與可能發生的風險)

特別是應具備人工管控的程序與監督流程,是需要特別關注的。

此外,AI服務使用者/應用者在導入前或上線前應對AI系統進行風險評估,建議的風險評估與管理措施包含:

- 根據AI服務提供商的文件說明辨識分析已知風險

- 評估AI系統本身是否有其他可能風險

- 根據應用的領域評估可能發生風險

- 導入合適的風險管理機制與衡量指標

各國對於AI應用監理規範或架構中,多數的規範對象以企業或機構為主;少有對個人使用者之規範 13。對於欲建構AI風險管理架構的AI服務使用者,可參考新加坡政府對於人工智慧應用所提出的使用者風險評估架構。為使AI服務提供商與使用者可以審視AI服務的風險層級,新加坡政府在2022年提供一套可信賴AI治理測試框架和工具包(Verify AI),適用於希望以客觀和可驗證的方式展現可信賴 AI 的公司,評估架構範本彙整於下表。

Verify AI評估架構

AI應用場景與AI系統的透明度 | 1. 透明度 |

AI模型決策透明性 | 2. 可解釋性 3. 重製性 |

AI系統的安全性與彈性 | 4. 安全性 5. 資安保護性 6. 穩健性 |

公平性/沒有非意圖性的偏見 | 7. 公平性 8. 資料治理 |

AI的管理與監督 | 9. 問責性 10. 人工管理與監督 11. 包容性成長及社會和環境友善 |

下方彙整由標準制定組織所發布的AI風險管理及治理相關標準,建議AI服務使用者或應用者可以參酌下列驗證標準將AI風險評估納入現行的風險管理和治理流程中,用以確保其使用的AI系統與相應服務達成其營運目標同時亦符合法規監管原則。

AI服務使用/應用者相關驗證標準

驗證標準 | 簡介 |

ISO/IEC 23894 - Information Technology - Artificial Intelligence - Risk Management | 《資訊科技—人工智慧—風險管理指南》 ISO 23894提供了在開發和應用AI技術和系統過程中管理風險的指南,幫助組織將風險管理整合到與AI相關的活動和職能中。該標準包括三項重點,分別是:

|

ISO/IEC AWI 42001 Information Technology - Artificial intelligence - Management system | 《資訊科技—人工智慧—管理系統》 ISO 42001係以風險為基礎(Risk-Based)的方法,旨在提供建立、實施、維護和不斷改進AI管理系統的要求,被設計為可作為可審計(Auditable)和可認證(Certifiable)的標準,融入組織的治理、風險和合規(GRC)14生態系統。 |

NISTIR 8332 | 《信任與人工智慧》 NISTIR 8332列出了具有9個評分指標的清單,用以評估AI使用者對AI產品或服務的潛在信任度,透過對於可信任AI的特徵拆解與量化分析,來了解使用者在使用AI產品或服務或受到AI產品或服務影響時如何感知信任程度,以精進可信任AI的產品與服務發展。 |

2. 風險評估建議

AI服務使用/應用者可用之風險評估方法論種類繁多,過去AI系統風險評估框架大多借鑑DPIA與PIA,較側重資訊安全,近期監管機構開始關注演算法系統風險評估議題,本章節將針對提演算法監管與風險評估方法做進一步的解析與說明。

參考相關演算法風險評估研究 15,評估演算法系統的方法可分為以下兩種類別:

- 演算法審查(Algorithm audits):為透過外部獨立機構查核與驗證確保演算法應用或AI工具的合規性,是較嚴謹且較受認可的風險評估方法。此審查方式可細分為特定系統應用流程查驗或全面查核兩種做法:

- 偏見審查 (Bias audit):僅評估演算法輸入、計算與輸出結果是否存在偏見。

- 合規檢查 (Regulatory inspection):對整個演算法系統根據特定法規或標準進行檢查,如數據保護法。通常由具有法定權力的監管機構或與開發人員合作的審計專業人員執行,並且檢查時也需考慮與該演算法系統相關的組織流程和使用者行為。

- 演算法影響評估(Algorithmic impact assessments):依據演算法系統生命週期的不同階段、影響的類型和被評估的系統類型,此評估方式可依據執行時間點分為以下兩種做法:

- 演算風險評估(Algorithmic risk assessment)16:在演算系統上線「前」評估其社會影響和風險的內部流程,建議持續監控。它全面評估系統實際使用情況和後續與用戶的互動,由系統商或採購方實施。

- 演算影響評估(Algorithmic impact evaluation):演算系統上線「後」對使用者或受影響單位進行評估,如:針對系統對特定客群的影響進行事後檢視或測試。

演算法系統風險評估方法

類別 | 演算法審查 | 演算法影響評估 | ||

做法 | 偏見審查 | 合規檢查 | 演算風險評估 | 演算影響評估 |

說明 | 針對性的方法,專注於評估演算系統是否存在偏見。 | 廣泛的方法,專注於評估演算系統是否符合法規或標準,需要使用多種不同的工具和方法。 | 在演算系統投入使用之前,評估其對社會可能產生的影響(通常建議進行持續監控)。 | 在演算系統投入使用後,評估其對使用者或受影響人群可能產生的社會影響。 |

時機 | 部署後 | 部署後、可能持續進行 | 部署前,可能持續進行 | 部署後 |

源起 | 社會科學 | 其他領域的監管審計,例如財務審計 | 環境影響評估、數據保護影響評估 | 政策影響評估,通常在事後進行評估 |

四、金融業AI監管與風險評估發展趨勢觀察

如同歐洲金融穩定研究所觀察 17「人工智慧包括機器學習(ML),具有顯著的潛力改善金融服務、營運和風險管理流程。科技已經成為金融服務的一部分,毫無疑問,它將繼續對消費者和金融機構產生深遠的變革。在此發展過程中,健全的監管框架對於最大程度發揮新技術的利益並最小化風險至關重要。」我國金管會銀行局亦於2023年10月公布《金融業運用人工智慧(AI)之核心原則與相關推動政策》,與國際組織及監管機構概念呼應。

除了原則性指引,我們也觀察到越來越多的聲音呼籲金融監管機構提供更具體的實用指導,以下針對歐洲保險局(EIOPA)的AI治理原則與框架進行實例解析說明 18,期望後續可作為相關金融機構建構風險治理框架與評估流程之參考。

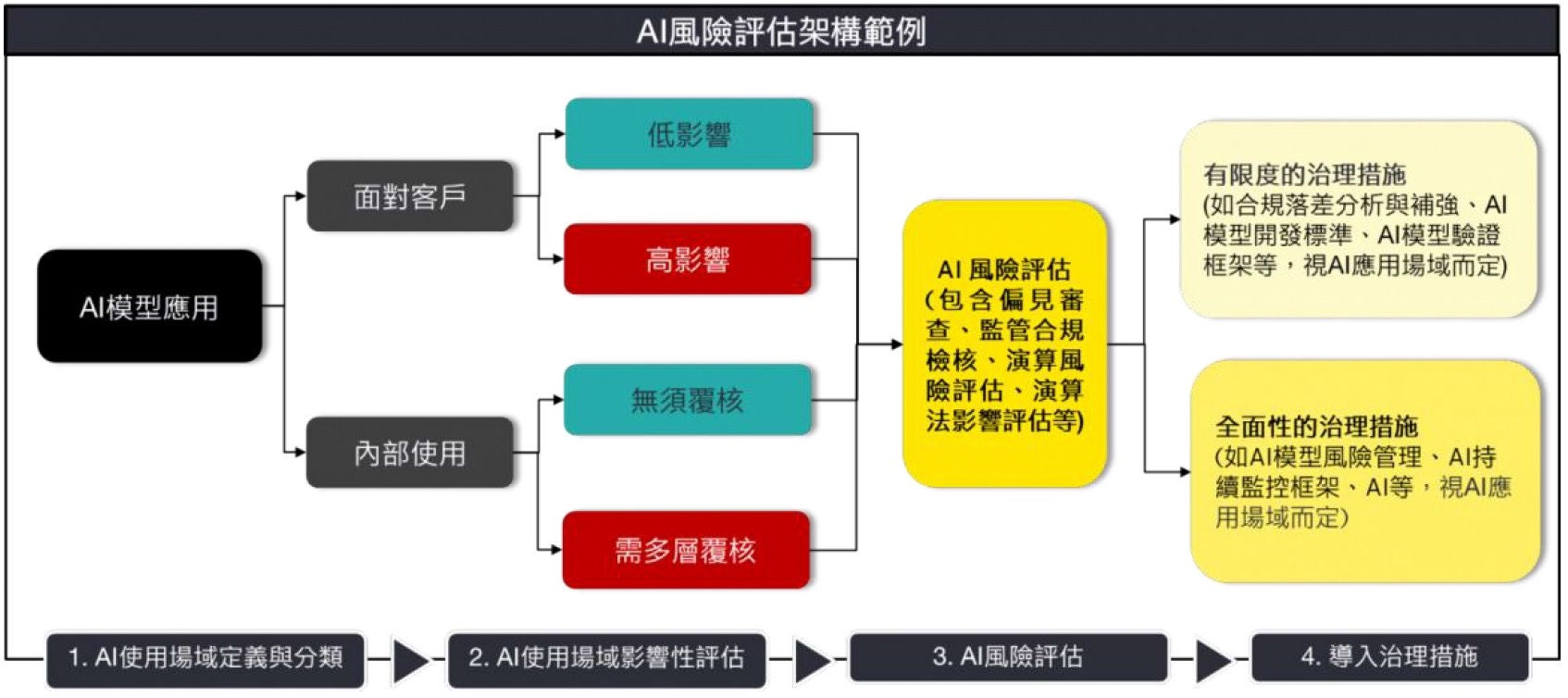

EIOPA:AI應 用場景與風險評估

參考FSI與EIOPA指引架構(圖例),金融機構可將使用的所有AI模型進行場域定義並分為兩類:「服務客戶使用」與「服務組織內部使用」,並邀請各部門與利益相關者對於該AI模型的完整生命週期(開發 — 部署)進行參與角色辨識與決策影響程度高低評分。舉例來說,針對「服務客戶使用」的類別,如:客服機器人,可請相關部門針對該AI模型對於「影響客戶程度」問卷進行回覆,若客服機器人在與客戶互動中,對客戶「人類自主性」影響程度低,則其「影響客戶程度」得分也會較其他AI工具低,可被分類為「低影響」。以風險為基礎考量,依據場域影響分類後的結果,若被分類為「低影響」的AI模型,僅需導入有限的治理措施,如:補強合規差異、AI模型開發標準等;但若判斷為「高影響」者,則建議導入全面性的治理措施,如:AI持續監控框架。

建議金融機構可結合內部需求與AI應用案例問卷結果加強或是建立對應AI風險管控機制與標準,使其開發與使用的AI模型均能符合監管期待且可被信賴。

結語

綜觀人工智慧風險評估可大致分成評估源於使用AI所產生的風險以及依據AI系統或應用所辨識的風險評估兩類,然而針對這兩類的風險評估方法都建立在隱私影響評估、環境影響評估、道德影響評估和人權評估等基礎之上。觀察各地區與領域發展的風險評估方法,都鼓勵企業,不論是AI系統的開發商或使用者思考下列問題:

- 何時為合適的風險評估啟始階段(在設計階段、採購前和/或使用期間)?

基於預算考量,多數企業都會選擇在AI工具或系統部屬前後進行風險評估。然而當使用的AI工具或方案複雜度越高則可能衍生較多的風險。在涉及較複雜的AI應用工具時,建議從設計開發階段到部署階段都需要進行相應的風險評估。

- 誰該參與或主導風險評估以避免的潛在利益衝突?

為了使風險評估可信,評估者不應僅限使用者參與。即使在同一組織內,評估者也應獲得管理層的授權,以評估風險並避免有風險被掩飾的可能。

- 在開發或使用AI過程中,風險評估結果若過高,是否有對應的解決方案?

企業在追求特定的人工智慧方案時應了解可能導致的負面影響和聲譽損害並依據風險評估結果判斷相應的風險抵減措施或解決方案。

- 是否需公開揭露AI風險評估結果?

要能達到可信賴的AI開發與使用,進行獨立的風險評估審查,並將結果交付公眾評核是至關重要,但企業若考慮商業和競爭敏感性,亦可選擇摘要揭露並向監管機構陳述不公開評估的原因。

我們相信任何監管與治理框架都需要基於不同風險基礎考量進行相應的調整,以適應其應用的司法管轄區法規體系。過程中,除了需要考慮適用於與人工智慧相關的數據、隱私法規和訊息安全等數位基礎設施的監管生態外,尚須具備明確標準的風險評估制度與流程以建構一個可信賴的AI發展應用體系與環境。

(本文由企業管理諮詢服務高旭宏執行副總經理、余庭瑄資深經理、黃秋樺資深顧問與廖婉丞資深顧問聯合撰寫)

相關內容

FATF所發布之40項建議文件一直以來即為各國在防制洗錢及打擊資恐議題上所遵循的標準之一,部分近期修訂之內容可能對於金融機構之日常作業帶來一定的影響。