Die internationale EY-Organisation besteht aus den Mitgliedsunternehmen von Ernst & Young Global Limited (EYG). Jedes EYG-Mitgliedsunternehmen ist rechtlich selbstständig und unabhängig und haftet nicht für das Handeln und Unterlassen der jeweils anderen Mitgliedsunternehmen. Ernst & Young Limited ist ein Schweizer Unternehmen mit Sitz in der Schweiz, das Dienstleistungen für Kunden in der Schweiz erbringt.

Der EU AI Act kommt. Was heißt das für Sie und welche Schritte sollten Sie bereits jetzt einleiten?

Überblick

- Der EU AI Act wird enorme Anforderungen an Unternehmen stellen. Daher ist es wichtig, sich bereits jetzt vorzubereiten.

- Kernschritte bestehen darin, ein Verständnis der eingesetzten KI-Lösungen zu gewinnen und ein AI-Management-System zu implementieren.

- Hierfür müssen klare Verantwortlichkeiten geschaffen werden und verschiedene Abteilungen wie IT, Rechtsabteilung, Compliance und Datenschutz zusammenarbeiten.

Der AI Act wurde als Reaktion auf die zunehmende und derzeit beinahe unregulierte Nutzung künstlicher Intelligenz entworfen. Gerade am Beispiel des Wirbels um ChatGPT und der folgenden Forderungen, die Forschung an KI zumindest kurzzeitig auszusetzen, bis ein vernünftiger Umgang gefunden ist, zeigt die Relevanz dieses Vorhabens. Ziel des AI Act ist es, einen verantwortlichen Einsatz der KI zu gewährleisten, bei dem der Nutzen für die Menschheit im Vordergrund steht, ohne dabei den technischen Fortschritt aufzuhalten.

Was ist der AI Act?

Als Verordnung ist er direkt für alle EU-Mitgliedstaaten verpflichtend anzuwenden und gilt im Wesentlichen ab 24 Monaten nach Inkrafttreten. Mit Beendigung des Trilogs am 8. Dezember 2023 haben sich der Rat der EU, die EU-Kommission und das EU-Parlament auf die wesentlichen Punkte des AI Acts geeinigt. Der finale Entwurf wurde am 13. März 2024 beschlossen und tritt 20 Tage nach der Veröffentlichung in Kraft – voraussichtlich Ende Mai 2024. Anschließend treten die ersten Regelungen bezüglich unzulässigen KI-Systemen bereits nach 6 Monaten in Kraft.

Worum geht es im AI Act?

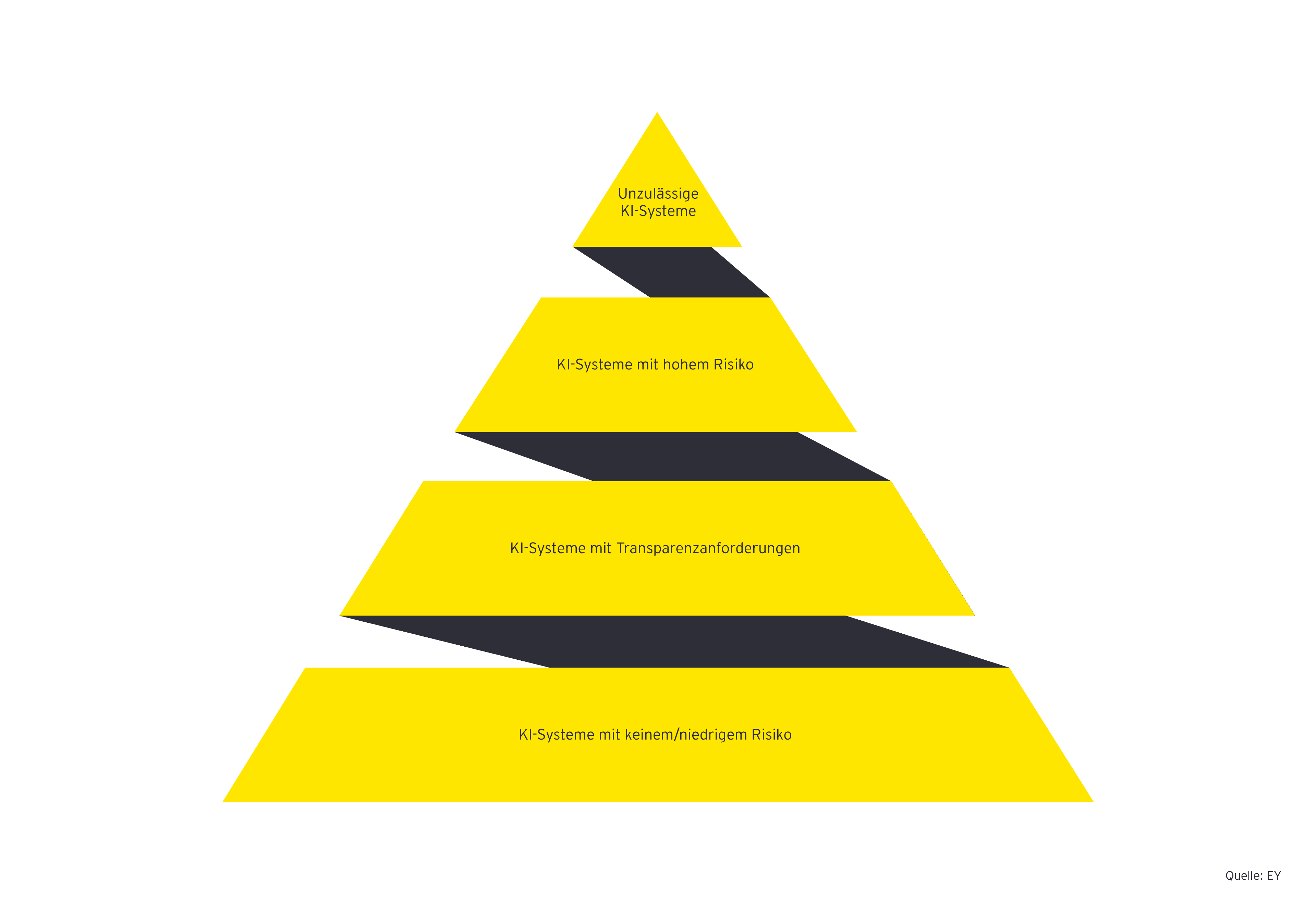

Der AI Act sieht einen risikobasierten Ansatz zur Regulierung von KI vor. Dafür werden KI-Systeme zunächst nach bestimmten Kriterien wie „Anwendungsfeld“ und „Zielgruppe“ in verschiedene Risikokategorien eingeordnet. Auf dieser Basis werden Maßnahmen definiert, die von Unternehmen, die KI-Systeme einer Kategorie einsetzen oder vertreiben, umgesetzt werden müssen. Die erforderlichen Maßnahmen erstrecken sich von einer einfachen Kennzeichnungspflicht für Anwendungen mit beschränktem Risiko (beispielsweise Chatbots im Kundenservice) über umfassende Dokumentations- und Sorgfaltspflichten für Anwendungen mit hohem Risiko (beispielsweise Anwendungen im Personalbereich) bis hin zu einem vollständigen Verbot für unzulässige Anwendungen oder solche mit inakzeptablem Risiko (beispielsweise Social Scoring oder Systeme mit einer unterschwelligen Manipulation des Verhaltens von Kindern oder von Menschen mit geistiger Behinderung).

Wie die obigen Beispiele zeigen, kann KI nicht nur in technischen Abteilungen, sondern im ganzen Unternehmen Anwendung finden. Doch klare Zuständigkeiten, Inventarlisten und Risikoeinschätzungen finden sich selten. Spätestens mit Inkrafttreten des AI Act werden diese allerdings notwendig, da bei Nichteinhaltung der Vorschriften drastische Bußgelder drohen. Als Höchststrafe sind 7 Prozent des gesamten weltweiten Vorjahresumsatzes oder 35 Millionen Euro vorgesehen. Dies übersteigt sogar die möglichen Bußgelder der DSGVO, die sich auf maximal 4 Prozent des Umsatzes oder 20 Millionen Euro belaufen. Doch wie sieht eine gute Vorbereitung aus?

In einem ersten Schritt müssen sich verantwortliche Stakeholder mit den Konzepten, den Anforderungen und den Konsequenzen des AI Act vertraut machen. Die Geschäftsleitung sollte über die neue Gesetzesinitiative informiert werden.

Bereit für den AI Act? Ein Fahrplan

Vor dem Inkrafttreten des AI Act: verstehen, prüfen, planen

In einem ersten Schritt müssen sich verantwortliche Stakeholder mit den Konzepten, den Anforderungen und den Konsequenzen des AI Act vertraut machen. Die Geschäftsleitung sollte über die neue Gesetzesinitiative informiert werden. Von ihr sollten klare Verantwortlichkeiten für die Implementierung der nötigen Anforderungen des AI Act festgelegt werden. Tatsächlich kann sich dieser Prozess schwierig gestalten, da hierfür unterschiedliche Funktionen innerhalb eines Unternehmens infrage kommen. Kann die Verantwortlichkeit nicht klar zugeordnet werden, sollte ein Gremium aus diesen Funktionen eingesetzt werden, das die Umsetzung orchestriert und an die Geschäftsleitung berichtet. Die relevanten Stakeholder sind die folgenden:

- Chief Technology Officer (CTO): Die IT- bzw. Technologie-Abteilung ist bei Digitalthemen wie KI der klassische Ansprechpartner. Die Erfüllung gesetzlicher Anforderungen durch ein entsprechendes Managementsystem mit Grundsätzen, Maßnahmen, Kontrollen und Dokumentationsanforderungen gehört jedoch typischerweise nicht zu ihren Kernbereichen.

- General Counsel Office (GCO): Da es sich beim AI Act um gesetzliche Anforderungen handelt, ist die Rechtsabteilung ebenfalls eine denkbare Option für die Verantwortung bzgl. der Anforderungen des AI Act. Jedoch liegen ein technisches Verständnis und auch der Unterhalt eines umfassenden Managementsystems nicht im klassischen Aufgabenbereich der Rechtsabteilung.

- Chief Compliance Officer (CCO): Im Bereich Compliance sind durch ein Compliance-Management-System (CMS) bereits viele Elemente eines Managementsystems für KI vorhanden. Durch das CMS hat die Compliance-Abteilung darüber hinaus bereits etablierte Kanäle zum Austausch mit diversen anderen Abteilungen. Sie ist auch mit Themen wie Risikoklassifizierung, Ableitung von Maßnahmen und deren Dokumentation vertraut. Darüber hinaus können die Anforderungen des AI Act in der Regel in einem bereits stattfindenden Regelprozess zur Risikoerfassung und bewertung eingegliedert werden. Seit Einführung der DSGVO liegt innerhalb der Compliance-Abteilung in der Regel auch ein gewisses technisches Verständnis vor, das für den AI Act nötig ist.

- Data Protection Officer (DPO): Neben der Compliance-Abteilung ist auch die Datenschutzfunktion eine durchaus geeignete Stelle, die für das Thema AI Act verantwortlich sein könnte, speziell wenn sie zu einer umfassenden Data-Governance-Funktion ausgebaut wird, die sich neben dem reinen Schutz der Daten auch mit deren Nutzung, der Gesetzmäßigkeit der IT-Landschaft und den damit verbundenen Risiken befasst. Zudem stellt die Datenschutzfunktion in der Regel die Schnittstelle aus CTO, GCO und CCO dar, unabhängig davon, wo sie im Unternehmen angesiedelt ist. Daher könnte es sinnvoll sein, das Thema AI Act bei einem:einer DPO anzusiedeln, sofern diese Stelle eigenständig besteht, und diese mit weiteren Ressourcen zur Erfüllung einer umfassenden Governance-Funktion auszustatten. Andernfalls erscheint eine Einordnung des Themas bei einer:einem CCO am sinnvollsten.

Zusätzlich zu diesen Funktionen sollten aus den operativen Bereichen oder dem mittleren Management Personen mit technischer und juristischer Detailexpertise über KI in ein solches Gremium mit eingebunden werden, um Detailfragen effizient klären zu können. Darüber hinaus sollten die aktuellen Gegebenheiten im Unternehmen wie beispielsweise bestehende Verantwortlichkeiten für verbundene Themen, eine möglicherweise vorhandene KI und/oder Innovationsstrategie, die Anwendungsbereiche der KI im Unternehmen und der bestehende Regelungsrahmen berücksichtigt werden. Diese und andere Faktoren können die oben beschriebene Einschätzung der geeigneten Verantwortlichkeit selbstverständlich beeinflussen.

Neben der Regelung der Verantwortlichkeit sollte zudem ein klarer, zeitlich festgelegter Maßnahmenplan definiert werden, anhand dessen die Anforderungen des AI Act basierend auf einer Gap-Analyse umgesetzt werden. Eine solche Gap-Analyse sollte auch die Eignung von Prozessen und Richtlinien, die bestehende Weiterbildung der Mitarbeitenden, das umfassende Verständnis der eingesetzten KI-Lösungen (beispielsweise durch ein KI-Inventar) und einige weitere Punkte berücksichtigen, auf die wir im Folgenden näher eingehen.

Nach der Annahme des AI Act gilt eine zweijährige Frist, um die genannten Vorgaben zu erfüllen. Innerhalb dieser Zeit ist der zuvor erarbeitete Maßnahmenplan umzusetzen.

Während der Übergangsphase: implementieren, überarbeiten, vorbereiten

Nach der Annahme des AI Act gilt eine zweijährige Frist, um die genannten Vorgaben zu erfüllen. Innerhalb dieser Zeit ist der zuvor erarbeitete Maßnahmenplan umzusetzen. Es sollte fortlaufend überprüft werden, ob die Meilensteine innerhalb des gesetzten Zeitplans erreicht werden.

Schritt 1: Inventar – Erhebung des Ist-Zustands

Sofern nicht bereits im Unternehmen verfügbar sollte ein umfassendes Inventar über Software, Anwendungen, Algorithmen und Lösungen mit KI-Bezug, die im Unternehmen verwendet werden, erstellt werden. Hierfür kann beispielsweise, sofern vorhanden, auf das Software-Asset-Management-System innerhalb der IT eines Unternehmens zurückgegriffen werden. Darin werden üblicherweise die installierte Software und deren zugehörige Lizenzen aller Rechner eines Unternehmens verwaltet.

Hiervon ausgehend kann für jede installierte Software überprüft werden, ob diese KI-Funktionalität verwendet oder potenziell für die Implementierung einer KI eingesetzt werden kann. Statt über einen manuellen Abgleich kann dies natürlich auch über Datenanalysen mit entsprechenden Softwaredatenbanken bzw. -listen erfolgen. Im Zweifel ist hier zunächst davon auszugehen, dass, sofern eine Software die Möglichkeit von KI anbietet, eine solche Funktionalität auch eingesetzt wird bzw. dass mit einer solchen Software auch eine KI implementiert wurde.

Diese Annahme sollte durch Befragungen/Fragebögen und Stichprobenprüfungen verifiziert und detailliert werden. Da die Bandbreite der möglichen Software und ihrer Funktionalitäten sehr groß ist, sollten die Gestaltung und die Auswertung dieser Befragung von Expert:innen begleitet werden, die ggf. bereits eine Liste von möglicher KI-Funktionalität je Software vorliegen haben und die Möglichkeiten der jeweiligen Software auf einer technischen Ebene bewerten können.

Wenn ein solches Asset-Management nicht vorhanden ist, kann mittels Fragebögen eine entsprechend breitere Erhebung im Unternehmen durchgeführt werden, ob KI-fähige Software eingesetzt wird. An der Durchführung ändert sich hierdurch, abgesehen vom Umfang der Befragung, nichts. Im Gegensatz zu einer vorab vorgenommenen Einschränkung der Befragten basierend auf installierten Softwarelösungen ist bei einer breiten Befragung die initiale Rückläuferquote allerdings üblicherweise deutlich geringer. Deshalb fällt der Managementaufwand für eine solche Befragung deutlich höher aus.

Unabhängig von der konkreten Form der Befragung ist diese immer so zu gestalten, dass am Ende alle nötigen Informationen über die im Unternehmen eingesetzte Software vorliegen, um die im Folgenden beschriebene Risikoklassifikation durchführen und entsprechende Nachweise für Anfragen von Behörden bereithalten zu können.

Aufbauend auf dieser ersten Einstufung und der daraus resultierenden Gruppierung in KI-Lösungen und Nicht-KI-Lösungen sollte die Klassifikation in die Risikokategorien des AI Act erfolgen.

Schritt 2: Klassifikation in Risikokategorien und Feststellung der Anforderungen

Aufbauend auf dieser ersten Einstufung und der daraus resultierenden Gruppierung in KI-Lösungen und Nicht-KI-Lösungen sollte die Klassifikation in die Risikokategorien des AI Act erfolgen. Hieraus ergeben sich dann die entsprechend umzusetzenden Anforderungen, die aus dem AI Act resultieren. Anschließend kann eine Evaluation der vorhandenen Maßnahmen im Unternehmen erfolgen, um die Konformität des Compliance-Management-Systems mit den Anforderungen des AI Act sicherzustellen. Eventuell vorhandene Lücken müssen vor Inkrafttreten geschlossen werden.

Risikokategorien und Anforderungen

Die Abgrenzung der Begriffe und Risikokategorien war ein großer Diskussionspunkt im Rahmen der Erstellung des Gesetzentwurfs. In dessen aktueller Version finden sich im Anhang eine Definition und eine Abgrenzung verschiedener Begriffe und Risikokategorien. Für die Definition von KI hat man sich beispielsweise an der Definition der OECD orientiert.

Gänzlich durch den AI Act als unzulässig eingestuft sind solche KI-Systeme, die als eine eindeutige Bedrohung für EU-Bürger:innen angesehen werden oder die Sicherheit und Gesundheit oder die Grundrechte von Menschen in einem solchen Maß gefährden, dass die Verhältnismäßigkeit zum vorgesehenen Einsatzzweck nicht gegeben ist. Hierzu gehören beispielsweise Social Scoring durch staatliche Akteure und die Verhaltensvorhersage von Personen zu Strafverfolgungszwecken („Predictive Policing“).

Für den Alltag der meisten Unternehmen sind voraussichtlich nur die folgenden drei der im AI Act aufgeführten Risikokategorien relevant:

KI-Systeme mit hohem Risiko sind solche, die Risiken für Gesundheit, Sicherheit oder Grundrechte von Menschen darstellen. Welche Einsatzgebiete und konkreten Anwendungszwecke dies genau umfasst, wird im Anhang des Gesetzes aufgelistet und nach Inkrafttreten laufend aktualisiert werden. Momentan umfasst diese Liste unter anderem Beschäftigung, Personalmanagement und Zugang zu selbstständiger Tätigkeit (zum Beispiel zur Auswahl von Bewerber:innen, zur Entscheidung hinsichtlich Beförderungen oder zur Kontrolle von Leistung und Verhalten von Arbeitnehmer:innen), Management und Betrieb kritischer Infrastruktur (zum Beispiel zur Steuerung von Stromnetzen oder des Schienenverkehrs) sowie Strafverfolgung, Rechtspflege, Migration und Asyl (zum Beispiel zur Vereinfachung von Entscheidungen). Auch die biometrische Überwachung von Personen fällt in diese Kategorie. Weiterhin ist ein hohes Risiko gegeben, wenn ein KI-System unter eine harmonisierte europäische Norm fällt, für die eine Konformitätsbewertung (d. h. eine Bewertung und Bestätigung/Zertifizierung) vorgesehen ist. Aufgeführt werden hier unter anderem Normen für Maschinen, Medizinprodukte, Spielzeug oder Aufzüge.

Die im AI Act formulierten Anforderungen an die genannten Hochrisikosysteme sind umfangreich:

1. Risikomanagement

Es muss ein Risikomanagement zum Zweck der Identifikation, Bewertung und Reduzierung von Risiken aufgebaut und auf die KI-Systeme angewendet werden.

2. Datenqualität

Es werden bestimmte Anforderungen an die für Training, Testen und Validierung eingesetzten Daten gestellt. Beispielsweise müssen diese Daten relevant, repräsentativ, frei von Fehlern und vollständig sein.

3. Dokumentation

Es müssen eine automatisierte Protokollierung des Betriebs und eine umfassende technische Dokumentation gegeben sein.

4. Transparenz- und Informationsanforderungen

Gegenüber den Nutzer:innen gelten bestimmte Anforderungen zur Transparenz und Information. Diese sind im Anhang zum AI Act näher definiert. Außerdem müssen eine menschliche Aufsicht und der Eingriff in das KI-System möglich sein.

5. Technische Anforderungen

Bestimmte Anforderungen bezüglich der Informationssicherheit müssen gegeben sein. Genauigkeit und Robustheit müssen einem angemessenen Maß entsprechen. Auch hier werden die genauen Anforderungen im Anhang des AI Act näher definiert.

Die Einhaltung der Anforderungen muss vor allem durch diejenigen gewährleistet werden, die die KI-Lösung betreiben. Sie sind dafür verantwortlich, die Einhaltung der Anforderungen zu bewerten und die KI durch einen Menschen zu überwachen. Weiterhin müssen KI-Systeme mit hohem Risiko in eine EU-Datenbank eingetragen werden. Auch nach der Inbetriebnahme bleibt es die Aufgabe des Betreibers, die KI-Systeme zu überwachen und Vorfälle an die zuständigen Stellen zu melden.

KI-Systeme mit Transparenzanforderungen sind solche, die mit Menschen interagieren, Emotionserkennung oder biometrische Kategorisierung betreiben oder künstliche Inhalte generieren, die realen Personen, Orten oder Gegenständen ähneln (sogenannte Deep Fakes). Diese Inhalte müssen auf eine bestimmte Weise gekennzeichnet sein, sodass die Nutzung der KI klar ersichtlich ist und die Erzeugung illegaler Inhalte verhindert wird.

KI-Systeme mit niedrigem Risiko sind solche, die voraussichtlich kein Risiko für die Nutzer:innen oder deren Daten bedeuten, beispielsweise zu Testzwecken in sogenannten Sandboxes eingesetzte KI-Lösungen. Für sie gelten Anforderungen im Bereich der allgemeinen Produktsicherheit. Es wird auch die freiwillige Erstellung von Verhaltenskodizes empfohlen, die sich an den Vorgaben für KI-Systeme mit hohem Risiko orientieren, jedoch auch weiter gehen können.

Anhand dieser Auswahl wird deutlich, dass eine Klassifizierung in die einzelnen Risikokategorien nur systematisch möglich ist. Besonders für Hochrisikosysteme gelten strikte Anforderungen und Dokumentationspflichten, die eine strukturierte Erhebung und Dokumentierung erfordern.

Neben diesen Systemen gelten besondere Anforderungen für sogenannte General Purpuse AI (GPAI). Die finale Definition solcher Systeme ist noch nicht bekannt, generell fallen darunter jedoch KI-Modelle, die anhand großer Datenmengen durch „self-supervised learning“ nicht nur für einen speziellen Zweck trainiert wurden, sondern für eine Vielzahl verschiedener Zwecke eingesetzt werden können. Hierzu gehören beispielsweise sogenannte „large language models“ wie GPT-3 und GPT-4 von OpenAI, die unter anderem in ChatGPT zum Einsatz kommen, oder das ebenfalls von OpenAI entwickelte DALL-E, aber auch das von Google entwickelte Bard.

Für solche Modelle gelten zusätzliche Anforderungen hinsichtlich der Transparenz, der Einhaltung von Copyright-Anforderungen und der Veröffentlichung einer „detaillierten Zusammenfassung“ der zum Training dieser Modelle genutzten Daten. Was genau unter dieser detaillierten Zusammenfassung zu verstehen ist, bleibt abzuwarten.

Sofern solche GPAI-Systeme mit einer hohen Rechenleistung erstellt wurden (die EU nennt hier eine Grenze von 1025 FLOPs (Floating Point Operations Per Second)), gelten weitere Anforderungen hinsichtlich der Evaluierung der Modelle, das Erfordernis von Analysen in Bezug auf systematische Risiken, die mit den Modellen verbunden sind, sowie Offenlegungs- und Berichtspflichten zu Vorfällen im Zusammenhang mit solchen GPAIs gegenüber der Europäischen Kommission.

Schritt 3: Klare Zeitpläne schaffen

Auch wenn nicht klar ist, ob der zeitliche Rahmen zum Inkrafttreten des AI Act eingehalten werden kann, bietet es sich an, eine erste Risikoeinschätzung der im Unternehmen vorhandenen Systeme bereits jetzt vorzunehmen, um auf ein Inkrafttreten vorbereitet zu sein, und ggf. schon jetzt entsprechende Maßnahmen zu implementieren, um den Anforderungen des AI Act gerecht zu werden. Das empfiehlt sich besonders für komplexe Unternehmensorganisationen oder solche mit einer Vielzahl von KI-Anwendungen. Wer sich frühzeitig vorbereitet, kann sich einigen Ärger ersparen und ggf. frühzeitig Regelungen erlassen, die bei der Neuentwicklung oder dem Einkauf von KI-Anwendungen im Unternehmen berücksichtigt werden müssen. Besonders die Umsetzung von Änderungen, die einen nachträglichen Eingriff in bereits implementierte und verwendete Anwendungen erfordert, bedeutet einen hohen Arbeitsaufwand und eine intensive Absprache mit den jeweiligen Betriebseinheiten. Umfangreiche Arbeitsaufträge kurz vor der Deadline führen schnell zu Unmut. Klare Zeitpläne und Arbeitsanweisungen erleichtern die Vorbereitung.

Schon jetzt arbeiten verschiedene Gremien wie beispielsweise die europäischen Normungsorganisationen CEN und CENELEC, aber auch ISO und IEC sowie verschiedene Industriegruppen an „Best practice“-Ansätzen und Normierungen rund um den AI Act. Außerdem gibt es mit dem EU AI Pact einen Aufruf der Europäischen Kommission an Unternehmen, die Anforderungen bereits jetzt umzusetzen, die „best practice“ mitzugestalten und sich mit anderen betroffenen Unternehmen zum AI Act auszutauschen.

Durch die Mitgliedschaft in vielen dieser Gremien kann EY Sie gerne dabei unterstützen, die Anforderungen besser zu verstehen, und Sie bei der Implementierung der Anforderungen zu begleiten.

Nach Inkrafttreten: umsetzen, überwachen, weiterentwickeln

Mit der Umsetzung der genannten Maßnahmen ist die Vorbereitung auf das Inkrafttreten des AI Act gelungen. Allerdings ist an dieser Stelle die Arbeit nicht abgeschlossen. Neu hinzukommende KI-Implementierungen müssen kontinuierlich überwacht und neue Anwendungen nach den gesetzten Prozessen und Standards entwickelt und erfasst werden. Ebenso muss der Prozess an die zu erwartenden regelmäßigen Ergänzungen in der Gesetzgebung angepasst werden. Nicht zu vernachlässigen ist auch die kontinuierliche Schulung und Aufklärung der Mitarbeitenden. Und auch Beratungs- und Beschwerdekanäle müssen etabliert und aufrechterhalten werden.

Zur kontinuierlichen Überwachung neuer Software und Anwendungen ist es empfehlenswert, ein System automatischer Kontrollen zu etablieren. Darin können beispielsweise neu hinzukommende Software bzw. deren Installationen hinterlegt werden. Im Fall der Installation einer Software, die möglicherweise unter die Regulierung des AI Act fällt, können aus einem solchen System z. B. Freigabe-Workflows an Vorgesetze oder speziell geschulte Mitarbeitende verschickt werden. So kann eine KI-Nutzung bereits vorab kontrolliert und anschließend im System der tatsächliche Einsatz getrackt werden. Außerdem können Informationen oder Fragebögen automatisch an die Anwendenden verschickt oder automatisch Online-Schulungen zu den zu beachtenden Einschränkungen für die Verwendung der entsprechenden Software initiiert werden.

Wichtig dabei ist es, sich im Unternehmen nicht nur auf einen regel- und kontrollbasierten Ansatz zu verlassen, sondern durch Schulungen und Kommunikation eine Kultur zu schaffen, die beim Einsatz von KI-Systemen die möglichen Risiken und Gefahren berücksichtigt und darauf hinarbeitet, diese zu minimieren bzw. vollständig zu mitigieren. Missverständnisse bezüglich der Zuverlässigkeit, fehlende Transparenz oder gar die unabsichtliche Diskriminierung durch Algorithmen bergen große Risiken. Der verantwortungsvolle Umgang mit KI birgt die Möglichkeit, bessere, leistungsfähigere und sicherere Modelle zu verwenden und sich damit auch künftig am Markt abzuheben.

Mit einem gut etablierten Kontrollsystem können durch diese oder ähnliche Maßnahmen viele der Anforderungen aus dem AI Act erfüllt und dokumentiert werden. Außerdem lassen sich für die Prüfung der Effektivität der Kontrollen aus einem solchen System gezielt Fälle für einen effizienten risikoorientierten Prüfungsansatz bestimmen. Hierdurch können Sie sich optimal auf mögliche externe Prüfungen der Einhaltung des AI Act in Ihrem Unternehmen vorbereiten, die durchaus auch ein Alleinstellungsmerkmal im Wettbewerb werden kann, solange sie frühzeitig erlangt wird.

Fazit

Verwendet Ihr Unternehmen KI? Viele denken hierbei an selbstfahrende Lieferfahrzeuge oder autonome Wartungsroboter und beantworten diese Frage intuitiv mit einer klaren Antwort. Doch stellen wir die Frage einmal anders: Verwendet Ihre Marketingabteilung ein System, mit dem personalisierte Werbung an Kund:innen verschickt wird? Welche Modelle benutzen Sie im Vertrieb, um Absatzprognosen zu erstellen? Wie genau sortiert Ihre Personalabteilung Bewerbungen vor? All dies sind potenzielle Anwendungsfelder von KI, die in naher Zukunft vom AI Act der Europäischen Union reguliert werden.

- Einzelne Anforderungen an die EU-Mitgliedstaaten gelten bereits drei bzw. zwölf Monate nach Verabschiedung.

- EY verfügt hierfür mit dem AI Discovery Tool beispielsweise über ein umfassendes Verzeichnis von Software, die für diese Zwecke eingesetzt werden kann. Gleichzeitig zeigt das Tool die Nutzung verschiedener Softwarelösungen in verschiedenen Abteilungen, Regionen und Funktionen an.

- „Social Scoring“ bezeichnet ein Rating-System, bei dem durch die Vergabe von Punkten für sozial als wünschenswert angesehenes Verhalten Punkte vergeben bzw. für nicht als wünschenswert angesehenes Verhalten Punkte abgezogen werden. Der Punktestand beeinflusst den Zugang zu Visa, Arbeitsplätzen usw. Bekannt ist es vor allem durch den Einsatz in der Volksrepublik China.

Switzerland is leading the AI transformation as it unfolds in Europe across sectors and countries – but the journey is far from over.

Five generative AI initiatives leaders should pursue now

Learn how to move beyond quick efficiency gains to a cohesive AI strategy that maximizes your growth potential in a fast-changing space.

How GenAI is reshaping private equity investment strategy

A balanced approach to investment strategy is needed to defend against GenAI disruption while also driving portfolio performance. Learn more.